Удаление повторяющихся строк в эксель: самые быстрые методы

Содержание:

- Метод 2: удаление повторений при помощи “умной таблицы”

- Обзор программы Duplicat Cleaner Pro

- Duplicate Cleaner Free

- Иные способы удаления дубликатов в Excel

- Работа с картами 1С 4 в 1: Яндекс, Google , 2ГИС, OpenStreetMap(OpenLayers) Промо

- Поиск и выделение дубликатов цветом

- DiskBoss

- Электронная таблица в 1С средствами табличного документа

- Обзор программы Audio Comparer

- Лучший и простой в использовании инструмент: Auslogics Duplicate File Finder

- Как избавиться от дублей страниц, проиндексированных в Яндексе и Google

- Удаление Дубликатов по Нескольким Критериям

- Виды дублей страниц на сайте

Метод 2: удаление повторений при помощи “умной таблицы”

Еще один способ удаления повторяющихся строк – использование “умной таблицы“. Давайте рассмотрим алгоритм пошагово.

- Для начала, нам нужно выделить всю таблицу, как в первом шаге предыдущего раздела.

- Во вкладке “Главная” находим кнопку “Форматировать как таблицу” (раздел инструментов “Стили“). Кликаем на стрелку вниз справа от названия кнопки и выбираем понравившуюся цветовую схему таблицы.

- После выбора стиля откроется окно настроек, в котором указывается диапазон для создания “умной таблицы“. Так как ячейки были выделены заранее, то следует просто убедиться, что в окошке указаны верные данные. Если это не так, то вносим исправления, проверяем, чтобы пункт “Таблица с заголовками” был отмечен галочкой и нажимаем ОК. На этом процесс создания “умной таблицы” завершен.

- Далее приступаем к основной задаче – нахождению задвоенных строк в таблице. Для этого:

- ставим курсор на произвольную ячейку таблицы;

- переключаемся во вкладку “Конструктор” (если после создания “умной таблицы” переход не был осуществлен автоматически);

- в разделе “Инструменты” жмем кнопку “Удалить дубликаты“.

- Следующие шаги полностью совпадают с описанными в методе выше действиями по удалению дублированных строк.

Примечание: Из всех описываемых в данной статье методов этот является наиболее гибким и универсальным, позволяя комфортно работать с таблицами различной структуры и объема.

Обзор программы Duplicat Cleaner Pro

Достаточно интересная утилита для поиска и удаления дубликатов файлов, причем не только аудиофайлов, но и любых других. Однако это ей никак не мешает эффективно справляться с поиском и удалением дублей аудиофайлов.

Особо можно отметить следующее: продуманный и интуитивный интерфейс! У новичка не должно возникнуть сложностей с освоением данной программы. Сразу после старта программы в главном окне будет отображено несколько вкладок:

1) Критерии поиска: указывается режим поиска (к примеру, режим аудио с указанием дополнительных критериев)

2) Сканировать путь: в данной вкладке указываются папки, в которых должен осуществляться поиск дублей

3) Дубликаты файлов (появляется после первого сканирования): окно, в котором отображаются результат поиска

4) Одинаковых папок (появляется после первого сканирования): окно, в котором отображаются директории, в которых находится полностью идентичное содержимое

Впечатление от работы данная программа оставила весьма достойное: пользоваться Duplicat Cleaner весьма удобно и довольно просто, множество настроек для сканирования дубликатов файлов, достаточно хорошие результаты сканирования и выявления дублей.

Данную программу однозначно можно порекомендовать к использованию.

Duplicate Cleaner Free

Duplicate Cleaner Free — приложение для поиска и удаления дубликатов файлов всех типов, включая графические изображения, видеоролики, текстовые документы и приложения. Для обеспечения высокой скорости и точности сканирования ПК используется алгоритм MD5 Hash. В программе есть возможность экспорта и импорта результатов сканирования в отдельном документе формата CSV, ат акже инструмент для предварительного просмотра файлов.

Утилита бесплатная, совместима с Windows (32/64 бит) и переведена на русский язык.

- обычный режим — поиск всех типов файлов с совпадением по точному содержанию;

- режим изображения — поиск фотографий сходству изображения;

- режим аудио — поиск только музыкальных композиций.

В разделе «Фильтры поиска» можно добавить или исключить файлы для сканирования, а также установить минимальный и максимальный размеры файлов для поиска дубликатов на компьютере. Также есть возможность установки даты создания и модифицирования файла для более точного поиска дубликатов.

123

В дополнительных параметрах можно добавить файлы нулевого размера в исключения, считать жесткие ссылки в файле, искать файлы с тем же именем и расширением. Чтобы начать сканирование компьютера на наличие дубликатов файлов, нажмите «Сканировать».

Преимущества Duplicate Cleaner Free:

- возможность пользоваться утилитой бесплатно;

- несколько режимов сканирования системы;

- простой и удобный интерфейс на русском языке;

- возможность создания списка исключений для сканирования ПК.

Недостатки:

нет инструмента для работы с облачными сервисами.

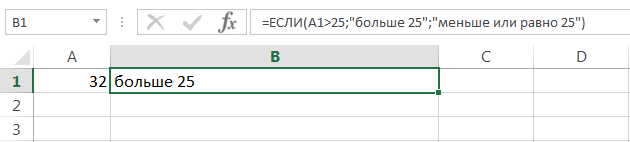

Иные способы удаления дубликатов в Excel

Итак, давайте подведем некоторые итоги касаемо того, как удалять повторы в Excel в разных ситуациях. Начем с повторений в одной колонке.

Удаление дубликатов в одном столбце

Если вся нужная информация находится в одной колонке, а требуется удаление повторяющихся данных, то нужно выполнить такие шаги:

- Выделить нужный диапазон.

-

Развернуть вкладку «Данные» на Панели инструментов и найти кнопку «Удалить дубликаты».

-

После этого появится окно, где возле пункта «Мои данные содержат заголовки» ставится флажок, если в соответствующем диапазоне заголовок имеется. Кроме этого, надо посмотреть на меню «Колонны», чтобы убедиться, что галочка стоит возле нужного столбца.

После того, как будет нажата кнопка «Ок», системой будут удалены все копии в столбце.

Удаление дубликатов в нескольких столбцах

Представим, что у нас есть таблица, в которой имена, сумма продаж и регион совпадают, но при этом отличаются даты.

26

26

Это может произойти, если при вводе информации в таблицу была допущена ошибка. Если необходимо удалить такие повторения, то нужно осуществить следующие действия:

- Выделить информацию в таблице.

-

Развернуть вкладку «Данные», там отыскать часть инструментов, обозначенную заголовком «Работа с данными», после чего кликнуть на знакомую нам кнопку «Удалить дубликаты». Дальше действия осуществляются аналогично, но при нужно не ставить флажок возле столбца с датой.

После этого все дубли будут убраны системой.

Удаление дублирующих строк с данными

Чтобы автоматически убрать все повторения строк, нужно выполнить такие действия:

- Выделить часть ячеек, где нужно убрать дубли.

-

После этого найти функцию «Удалить дубликаты» и выполнять те же действия, что описаны выше. Но в этом случае надо убедиться в том, что все флажки стоят. Тогда Эксель автоматически проверит всю информацию на предмет наличия в ней повторяющейся.

После нажатия ОК мы получаем нужный нам результат.

Работа с картами 1С 4 в 1: Яндекс, Google , 2ГИС, OpenStreetMap(OpenLayers) Промо

С каждым годом становится все очевидно, что использование онлайн-сервисов намного упрощает жизнь. К сожалению по картографическим сервисам условия пока жестковаты. Но, ориентируясь на будущее, я решил показать возможности API выше указанных сервисов:

Инициализация карты

Поиск адреса на карте с текстовым представлением

Геокодинг

Обратная поиск адреса по ее координатами

Взаимодействие с картами — прием координат установленного на карте метки

Построение маршрутов по указанным точками

Кластеризация меток на карте при увеличении масштаба

Теперь также поддержка тонкого и веб-клиента

1 стартмани

Поиск и выделение дубликатов цветом

Чтобы выделить дубликаты на фоне других ячеек каким-то цветом, надо использовать условное форматирование. Этот инструмент имеет множество функций, в том числе, и возможность выставлять цвет для обнаруженных дубликатов.

В одном столбце

Условное форматирование – это наиболее простой способ определить, где находятся дубликаты в Excel и выделить их. Что нужно сделать для этого?

-

Найти ту область поиска дубликатов и выделить ее.

-

Переключить свой взор на Панель инструментов, и там развернуть вкладку «Главная». После нажатия на эту кнопку появляется набор пунктов, и нас, как уже было понятно исходя из информации выше, интересует пункт «Повторяющиеся значения».

-

Далее появляется окно, в котором нужно выбрать пункт «Повторяющиеся» и нажать на клавишу ОК.

Теперь дубликаты подсвечены красным цветом. После этого нужно их просто удалить, если в этом есть необходимость.

В нескольких столбцах

Если стоит задача определить дубликаты, расположенные больше, чем в одной колонке, то принципиальных отличий от стандартного использования условного форматирования нет. Единственная разница заключается в том, что необходимо выделить несколько столбцов.

Последовательность действий, в целом, следующая:

- Выделить колонки, в которых будет осуществляться поиск дубликатов.

- Развернуть вкладку «Главная». После этого находим пункт «Условное форматирование» и выставляем правило «Повторяющиеся значения» так, как это было описано выше.

-

Далее снова выбираем пункт «Повторяющиеся» в появившемся окошке, а в списке справа выбираем цвет заливки. После этого кликаем по «ОК» и радуемся жизни.

Дубликаты строк

Важно понимать, что между поиском дублей ячеек и строк есть огромная разница. Давайте ее рассмотрим более подробно

Посмотрите на эти две таблицы.

1718

Характерная особенность тех таблиц, которые были приведены выше, заключается в том, что в них приводятся одни и те же значения. Все потому, что в первом примере осуществлялся поиск дубликатов ячеек, а во втором видим уже повторение строк с информацией.

Итак, что нужно сделать для поиска повторяющихся значений в рядах?

- Создаем еще одну колонку в правой части по отношению к таблице с исходной информацией. В нем записывается формула, которая выводит объединенную информацию со всех ячеек, входящих в состав строки. =A2&B2&C2&D2

-

После этого мы увидим информацию, которая была объединена.

- После этого следует выбрать дополнительную колонку (а именно, те ячейки, которые содержат объединенные данные).

- Далее переходим на «Главная», а затем снова выбираем пункт «Повторяющиеся значения» аналогично описанному выше.

- Далее появится диалоговое окно, где снова выбираем пункт «Повторяющиеся», а в правом перечне находим цвет, с использованием которого будет осуществляться выделение.

После того, как будет нажата кнопка «ОК», повторы будут обозначены тем цветом, который пользователь выбрал на предыдущем этапе.

Хорошо, предположим, перед нами стоит задача выбрать те строки, которые располагаются в исходном диапазоне, а не по вспомогательной колонке? Чтобы это сделать, нужно предпринять следующие действия:

- Аналогично предыдущему примеру, делаем вспомогательную колонну, где записываем формулу объединения предыдущих столбцов. =A2&B2&C2&D2

-

Далее мы получаем все содержащиеся в строке значения, указанные в соответствующих ячейках каждой из строк.

-

После этого осуществляем выделение всей содержащиеся информации, не включая дополнительный столбец. В случае с нами это такой диапазон: A2:D15. После этого переходим на вкладку «Главная» и выбираем пункт «Условное форматирование» – создать правило (видим, что последовательность немного другая).

-

Далее нас интересует пункт «Использовать формулу для определения форматируемых ячеек», после чего вставляем в поле «Форматировать значения, для которых следующая формула является истинной», такую формулу. =СЧЁТЕСЛИ($E$2:$E$15;$E2)>1

Для дублированных строк обязательно установить правильный формат. С помощью приведенной выше формулы можно осуществить проверку диапазона на предмет наличия повторов и выделить их определенным пользователем цветом в таблице.

23

DiskBoss

нельзя полностью отнести к классу программ для удаления дубликатов файлов. Это лишь одна из функций, помимо которой утилита умеет очень и очень многое. DiskBoss – это оптимизатор дискового пространства и усовершенствованный файловый менеджер. Он предназначен для анализа использования накопителей и управления всеми объектами, которые на них находятся.

Функции и возможности DiskBoss

- Исследование дискового пространства с отображением на круговой диаграмме, сколько места занимают те или иные объекты.

- Классификация, сортировка и группировка файлов и папок по множеству критериев, в том числе по правилам пользователя.

- Поиск и очистка дубликатов на рабочих станциях и серверах под управлением Windows. Гибкие критерии поиска.

- Несколько вариантов действий с найденными дубликатами – удаление, архивация, перенос в другое место и т. д.

- Замещение удаленных дубликатов ссылками.

- Сохранение отчетов сканирования и очистки дисков от дублированных данных в форматах html, excel, pdf, txt, csv и xml.

- Отображение результата поиска дубликатов на круговых диаграммах.

- Создание и выполнение автоматических сценариев по очистке дисков.

- Улучшенная система поиска данных на диске.

- Синхронизация данных в указанных каталогах.

- Удаление групп файлов на основе заданных критериев.

- Мониторинг изменений в файловой системе дисков в реальном времени.

- Анализ целостности и прочие операции с файлами.

- Многое другое.

Утилита DiskBoss будет хорошим выбором для тех, кому нужна полная картина содержимого и состояния дисков, а также возможность управлять всеми данными на них, используя ручные и автоматические методы. Приложение выпускается в бесплатной и нескольких платных версиях, причем первая содержит почти всё, что есть в платной версии pro, кроме нескольких инструментов автоматизации.

Пожалуй, единственный недостаток DiskBoss – отсутствие русского языка, но ради такого богатства функций с этим можно смириться. В остальном утилита очень хороша, а для некоторых задач – незаменима.

***

Конечно, это далеко не исчерпывающий список программ, предназначенных для удаления идентичных копий файлов. Их десятки, а может, и сотни. Однако этого скромного набора достаточно, чтобы удовлетворить потребности 90% пользователей Windows. Надеюсь, что что-то из них пригодится и вам.

Электронная таблица в 1С средствами табличного документа

Функционал электронной таблицы для программ на платформе 1С реализован на основе табличного документа. Функционал реализован в виде обработки (тонкий клиент). В формулах электронной таблицы можно использовать любые языковые конструкции, процедуры и функции 1С, ссылки на другие ячейки электронной таблицы. Допустимо обращаться к ячейкам электронной таблицы по имени именованной области. В случае использования в формулах электронной таблицы данных из самой таблицы пересчет зависимых ячеек с формулами производится автоматически. Электронную таблицу можно сохранить в файл формата xml.

1 стартмани

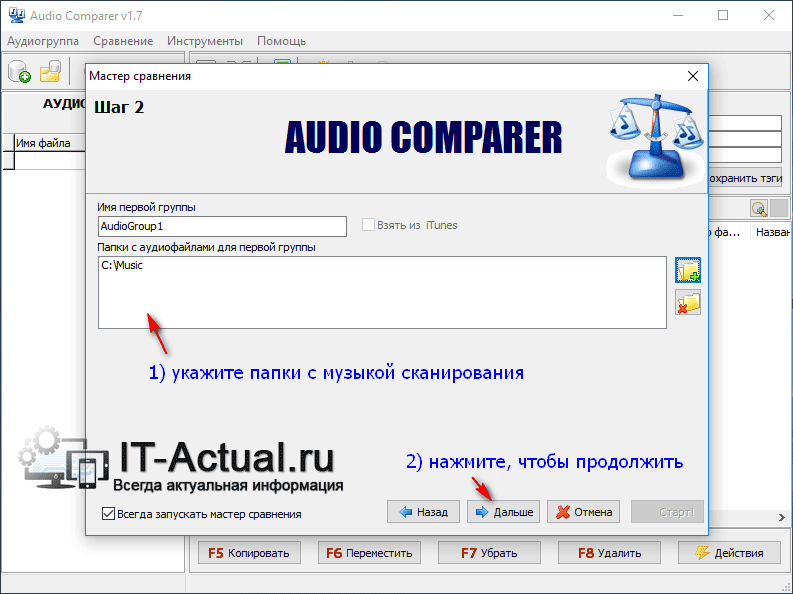

Обзор программы Audio Comparer

Данная утилита относится к редко встречающейся категории программ – поиску схожих аудио треков, не по размеру, вписанным тегам или имени файла, а по непосредственному содержанию (звучанию) аудиоряда. Сканирование аудиотреков занимает некоторое время, но благодаря этому достигается высокая эффективность в поиске и определении как полных по содержанию копий аудиофайлов, так и весьма схожих по звучанию, которые располагаются в разных папках вашего персонального компьютера.

При запуске программы будет открыто окно мастера, в котором необходимо будет указать папку(ки) сканирования и выбрать, что вы хотите найти: полные копии или схожие по звучанию. На последнем этапе окна мастера необходимо будет указать имя файла и путь для файла-отчёта. Этот файл может вам пригодиться, если вам понадобится наглядно увидеть результаты сканирования в будущем.

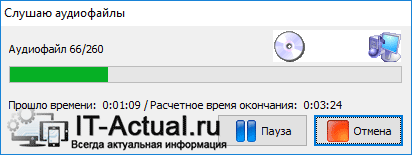

Если у вас очень большая коллекция, то сначала рекомендуется провести сканирование между небольшой группой аудиофайлов, дабы разобраться в основных принципах работы программы. А уже после этого просканировать всю вашу коллекцию.

После указания всех аудиофайлов и остальных параметров запустите процесс сканирования. Если сканируемых файлов очень много, то процесс займёт некоторое время. К примеру, 6 тысяч аудиотреков были просканированы за полтора часа.

По окончании сканирования отобразится окно с результатами. В нём, напротив каждого трека, для которого были найдены схожие композиции – будет отображён процент схожести. Прослушав их (в программе имеется штатный плеер для воспроизведения и оценки «на слух» схожих композиций), вы сможете выбрать, какую из копий оставить, а какую удалить. Всё достаточно наглядно и удобно.

Лучший и простой в использовании инструмент: Auslogics Duplicate File Finder

Некоторые вещи выбивают Auslogics из колеи из-за дополнительного мусора, но с тех пор они несколько исправили свои алгоритмы. Кстати установщик предлагает установить Auslogics Driver Updater как средство поиска дубликатов файлов. Обязательно снимите флажки с любого дополнительного программного обеспечения, предлагаемого в процессе установки, так как Вам не нужно средство обновления драйверов. Скорее всего.

Это приложение имеет разумные настройки по умолчанию и предлагает простой мастер, который проведет вас через весь процесс. Он будет сканировать несистемные папки на всех подключенных дисках по умолчанию, но вы можете легко выбрать, какие диски и папки Вы хотите сканировать и сами, — на боковой панели.

После того, как вы выполнили поиск, вы увидите список дубликатов файлов и сможете легко просматривать их превью и другую информацию. Или, чтобы еще больше сузить круг, вы можете нажать кнопку «Фильтр» и выполнить фильтрацию по дате, размеру или типу файла. Выберите файлы, которые вы хотите удалить, и нажмите кнопку «Удалить выбранные файлы», чтобы отправить их в корзину.

Процесс удаления дубликатов так же нечеловечески прост.

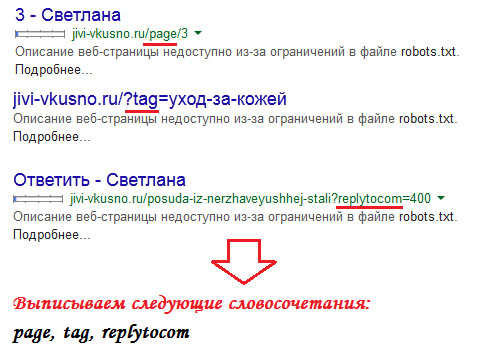

Как избавиться от дублей страниц, проиндексированных в Яндексе и Google

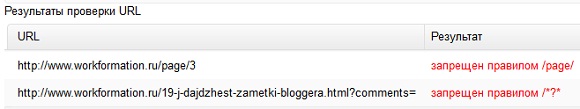

Итак, с различными методами разобрались, пришло время узнать пошаговый план удаления дубликатов в Яндексе и Гугле. Перед тем, как проводить зачистку, необходимо найти все дубли страниц — об этом я писал в прошлой статье. Нужно перед глазами видеть, какие элементы адресов страниц отражены в дублях. Например, если это страницы с древовидными комментариями или с пагинацией, то мы фиксируем содержащие в их адресах слова «replytocom» и «page»:

Замечу, что для случая с replytocom можно взять не это словосочетание, а просто вопросительный знак. Ведь он всегда присутствует в адресе страниц древовидных комментариев. Но тогда нужно помнить о том, что уже в урлах оригинальных новых страниц не должно быть символа «?», иначе и эти станицы уйдут под запрет.

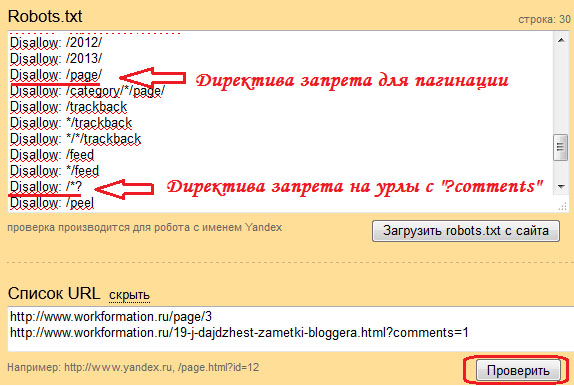

Чистим Яндекс

Для удаления дублей в Яндексе создаем правила блокировки дубликатов с помощью директивы Disallow. Для этого совершаем следующие действия:

- Открываем в Яндекс Вебмастере специальный инструмент «Анализ robot.txt».

- Вносим в поле директив новые правила блокировки дублей страниц.

- В поле «список URL» вносим примеры адресов дубликатов по новым директивам.

- Нажимаем кнопку «Проверить» и анализируем полученные результаты.

Если мы все верно сделали, то данный инструмент покажет о наличии блокировки по новым правилам. В специальном поле «Результаты проверки URL» мы должны увидеть красную надпись о запрете:

Чистим Google

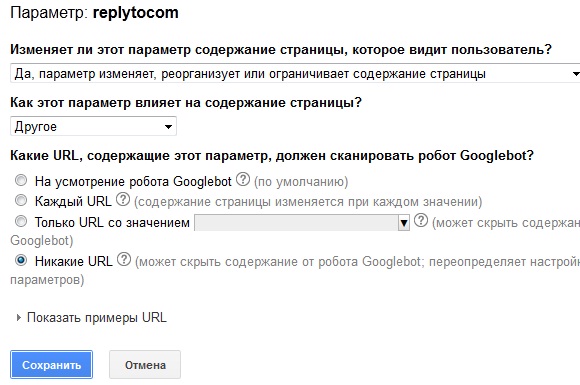

С Гуглом не все так просто. Запретные директивы в robots.txt не удаляют дубли в индексе этой поисковой системы. Поэтому нам придется все делать своими силами. Благо для этого есть отличный сервис Google вебмастер. А конкретно нас интересует его инструмент «Параметры URL».

Именно благодаря этому инструменту, Google позволяет владельцу сайта сообщить поисковику сведения о том, как ему нужно обрабатывать те или иные параметры в урле. Нас интересует возможность показать Гуглу те параметры адресов, страницы которых являются дублями. И именно их мы хотим удалить из индекса. Вот что нам нужно для этого сделать (для примера добавим параметр на удаление дублей с replytocom):

- Открываем в сервисе Гугла инструмент «Параметры URL» из раздела меню «Сканирование».

- Нажимаем кнопку «Добавление параметра», заполняем форму и сохраняем новый параметр:

В итоге у нас получается прописанное правило для пересмотра Гуглом своего индекса на наличие дублированных страниц. Таким образом дальше мы прописываем следующие параметры для других дубликатов, от которых хотим избавиться. Например, вот так выглядит часть моего списка с прописанными правилами для Гугла, чтобы он подкорректировал свой индекс:

На этом наша работа по чистке Гугла завершена, а мой пост подошел к концу. Надеюсь, эта статья принесет Вам практическую пользу и позволит Вам избавиться от дублей страниц Ваших ресурсов.

Удаление Дубликатов по Нескольким Критериям

Давайте вернемся, к казалось бы, простому меню, которое у нас выскакивает при выделенных данных. В этом списке представлены все колонки нашей Excel таблицы. Вы можете заметить, что каждой колонке соответствует свой чекбокс.

Зачем нам нужно это меню? Главным образом, оно позволят нам уточнить для Excel, каким образом будут удалять повторы. Давайте рассмотрим пример:

Пример Удаления Дубликатов по одному фактору.

На скриншоте выше, я опять выделили данные и нажал на кнопку Удалить Дубликаты. Затем, я снял выделения в чекбоксах, за исключением одного — «Chef». Результат показан в нижней половине картинки. Заметьте, что наша таблица уменьшилась всего на три строки, на те в которых повторялось имя шефа.

Когда мы отмечаем только чекбокс с названием «Chef», мы просим Excel, искать повторы только в колонке Chef. Первый раз, как он видит повторяющееся имя в колонке chefe, то он удаляет целую строку, в независимости от того, чем отличаются другие колонки.

Будьте Осторожны Удаляя Повторяющиеся Строки в Excell

И вот почему так важно соблюдать осторожность при использовании функции «Удалить Дубликаты». Если вы оставите удаление по одному фактору, то вы можете случайно удалить данные, которые на самом деле нужны

Совет: окошки, которые вы оставляете отмеченными в окне Удаления Дубликатов — это комбинации по которым Excel будет проверять повторы. Оставляйте отмеченными несколько чекбоксов, для более аккуратного удаления.

Часто, одной колонки не достаточно, что бы достоверно судить о наличии повторов. Если у вас есть онлайн магазин, и вы ведете базу данных по покупателям, велики шансы, что среди ваши данных есть более чем одно упоминание покупателя «Mike Smith». Вы должны отмечать несколько колонок, для правильного удаления дубликатов, такие как имя покупателя, его адрес или дата регистрации. Вот почему мы отмечаем несколько колонок.

Если вы хотите, чтобы удаление повторов было более точным, оставляйте отмеченными несколько чекбоксов (колонок), когда используете функцию Удалить Дубликаты. И кончено же, всегда дважды проверьте ваши данные, после использования этой функции.

Когда Нужно Быть Избирательным

Если вы используете таблицу с примерами, откройте вкладку Duplicate Shifts, для этой части урока.

Вы можете задаться вопросом: а может быть ситуация, где вам действительно придется снять галочки с каких-то окошек? Конечно может. Давайте рассмотрим следующий пример.

В таблице ниже у меня есть данные о рабочей смене сотрудников, и я случайно загрузил данные два раза. Для каждого сотрудника есть время прихода и ухода, и плюс к этому есть колонка с датой, когда я загрузил отчет. Присутствуют повторы для каждой строки, за исключением одной колонки F, где стоит Дата Загрузки Отчета.

Мне необходимо удалить повторы, потому что отчет был ошибочно загружен дважды (посмотрите на последнюю колонку), но мне нужно исключить последнюю колонку из проверок по дубликатам.

Давайте подумаем: если я отмечу все колонки для поиска повторов, Excel не найдет дубликатов. Но, я на самом деле хочу удалить повторы в рабочих сменах

Мне на самом деле не важно, в какой день я загрузил отчет, поэтому я должен исключить колонку F, при оценке повторяющихся строк

Мои строки почти что те же; отличия только в колонке F, я не хочу, чтобы Excel оценивал ее при поиске повторов. Если я оставлю галочки во всех чекбоксах, Excel вообще не найдет повторов.

Эти строки не совсем повторы — в них не все повторяется, но мне нужно удалить дубликаты, основываясь на данных в колонках A-E.

Что бы сделать это, я снова выделяю таблицу и снова запускаю функцию Удалить Дубликаты. На этот раз, я оставил отмеченными все чекбоксы, за исключением Report Download Date (дата загрузки отчета).

Заметьте, что Excel удалил дубликаты, потому что он игнорировал и не стал проверять в процессе работы алгоритма колонку F.

Вы можете представить себе это таким образом: те чекбоксы которые вы оставили отмеченными, соответствуют тем колонкам, которые Excel стал рассматривать в ходе поиска повторов. Если есть особые колонки, в которых не надо искать дубликаты, то снимите соответствующие галочки в окне Удалить Дубликаты.

Виды дублей страниц на сайте

Дубликаты бывают трех видов:

- Полные — с полностью одинаковым контентом.

- Частичные — с частично повторяющимся контентом.

- Смысловые — когда несколько разделов несут один смысл, переданный разными словами.

Анализируя структуру сайта, эксперты чаще реагируют на полные совпадения, хотя поисковые системы замечают и частичные, и смысловые.

1. Полные

Полный аналог ухудшает факторы внутренней оптимизации всего сайта и затрудняет его продвижение в ТОП, что крайне нежелательно. Поэтому их надо ликвидировать сразу после обнаружения.

К ним относятся:

- Версия с/без www. Возникает, если пользователь не указал зеркало в панели «Яндекса» и Google.

- Различные варианты главной страницы:

- site.net/index.html;

- site.net/index/;

- site.net/index;

- site.net.

- Страницы, которые появляются при ошибочной иерархии разделов:

- site.net/category/gift/;

- site.net/products/gift/;

- site.net/products/category/gift/.

- UTM-метки. Они используются, чтобы передавать данные для анализа рекламы и источника переходов. Поисковики их обычно не индексируют, но иногда бывают исключения.

- GET-параметры в URL. Иногда при передаче данных GET-параметры попадают в адрес:

- Разделы, сгенерированные реферальной ссылкой. Обычно их выделяют специальным параметром, добавляемым к URL. На такой ссылке должен стоять редирект на обычный URL, но этим часто пренебрегают.

- Если неправильно настроить раздел с ошибкой 404, то он спровоцирует появление бесконечного количества дублей. Любые символы в адресе сайта автоматически превратятся в ссылку и без редиректа выдадут ошибку 404.

Прекратить появление дубликатов с полным совпадением можно, если поставить редирект, убрать ошибку программным путем или закрыть ресурс от индексации.

2. Частичные

Дубликаты с частичным совпадением меньше влияют на сайт. Трудно сказать, сколько дублей страниц сайта допустимо. Но если их слишком много, то это снижает позиции ресурса в поисковой выдаче, а также мешает его продвижению по конкретным ключевым запросам. Осталось выяснить, как частичные дубли появляются на сайте.

Характеристики в карточке товара

Описание товара на странице может иметь дополнительные вкладки, например отзывы или характеристики. Переключившись на одну из них, можно отследить изменение URL, хотя большая часть информации не меняется. Это и создает дубль.

Пагинация

Если система управления контентом настроена неверно, то при переходе на следующую страницу в одной категории URL меняется, а Title и Description остаются теми же. В результате получаем несколько различных ссылок с одинаковыми метатегами:

- site.net/category/notebooks/?page=2;

- site.net/category/notebooks/.

Поисковый алгоритм проиндексирует эти URL-адреса как разные документы. Этого можно избежать — надо лишь проверить реализацию вывода товаров и автогенерации с технической стороны.

Кроме этого, на каждом документе пагинации надо будет указать каноническую страницу как главную на сайте.

Подстановка контента

Когда владельцы ресурса хотят увеличить количество посещений по запросам с указанием города, они добавляют на сайт кнопку выбора региона. При переходе в другой город на странице с контактами меняется номер телефона. Но бывают случаи, когда в адресной строке появляется такой аргумент, как, например, «wt_city_by_default=..». В результате документ получает несколько дублей с разными ссылками. Подобная генерация недопустима, старайтесь использовать 301 редирект.

Версия для печати

Подразумевает точную копию содержимого раздела, но в другом, преобразованном формате, например:

- site.net/blog/content;

- site.net/blog/content/print — версия для печати.

Чтобы не создавать множество дубликатов, их надо закрывать от индексации в robots.txt.

Смысловые

Чтобы обнаружить смысловые дубли, а точнее статьи, написанные под запросы из одного кластера, необходимо провести парсинг сайта, например, с помощью программы Screaming Frog. Затем добавить в любой Hard-кластеризатор скопированные заголовки всех статей с порогом группировки 3,4. Смысловые дубли обязательно окажутся в одном кластере. Надо оставить лучшую статью, а с остальных поставить 301 редирект.