Как оценить качество системы a/b-тестирования

Содержание:

- Как работает A/B тестирование.

- Реальные данные

- Курс «Интернет-маркетолог» от TexTerra

- Результаты оценки качества метрик

- Элементы эксперимента

- Статистика нам в помощь

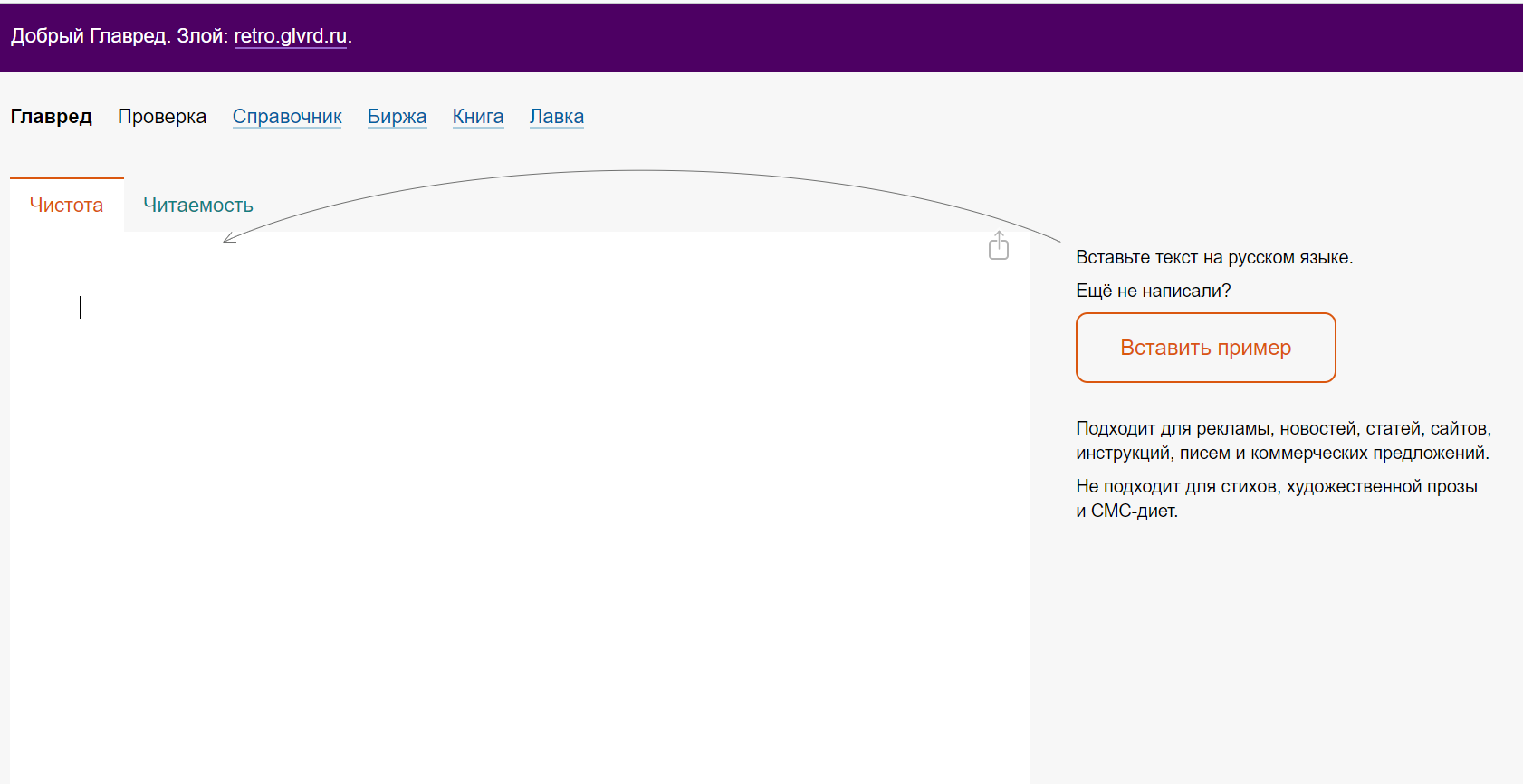

- Сервис #10

- Выводы

- Perfomance-подход

- Что делать с результатами

- A/B-тестирование мобильных приложений

- Зачем нужен A/A-тест (A/A/A-тест)

- Что такое А/Б-тестирование сайта

- Объекты А/Б-тестирования

- Что тестировать на странице

- Зачем тестировать разные варианты

- A/B-тестирование на примере сервиса «Стилист»

- Нулевой итог работы

Как работает A/B тестирование.

Допустим, Вы ведете рекламную кампанию, или у Вас есть какой-то магазин, получающий трафик из выдачи. Вроде все нормально — и лендинг красивый, и трафик идет, а метрики показывают, что посетители на сайте не задерживаются, страницы не просматривают, форму заполнять не желают и, соответственно, продаж нет или крайне мало.

Бюджет уходит в небо, и Вы понимаете — с лендом не все в порядке и нужно что-то менять, чтобы зацепить посетителя. Вариантов оптимизации много — от смены цвета и текста кнопок до корректировки контента и расположения элементов. Но что из этого сработает и как скажется на конверсии — непонятно.

Можно, конечно, проводить правки сайта и запускать новые рекламные кампании, набирая статистику и делая сравнения результатов, но это довольно долго — для достижения порога статистической достоверности необходимо набрать как минимум 250-300 конверсий, а на это нужно время.

Для этих целей и служит сплит тестирование. Берется исходный вариант сайта — назовем его A, меняем, к примеру, первый текстовый блок — это будет вариант B. Затем через специальный сервис гоним трафик, разделенный поровну на эти две версии сайта.

Получаем сравнительную статистику и оцениваем полезность нововведений. Если сработало, оставляем обновленный вариант и пробуем оптимизировать следующие элементы, если же поведенческие факторы и конверсия стали хуже — отменяем правки.

Что это дает? Много, иначе такой инструмент не был бы столь популярен у арбитражников и СЕО-шников — например, новый заголовок или сокращение количества полей в форме заказа может увеличить CR на порядок, а в деньгах это весьма и весьма ощутимо.

Оптимизация через А/Б тест всегда ведет к повышению продаж от 1% до 100% и более. И хотя в среднем срабатывает один эксперимент из трех-четырех, а остальные практически не сказываются на показателях, есть смыл тестировать и находить лучшее решение — оно того стоит и времени занимает немного.

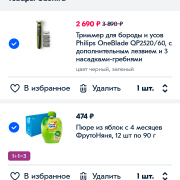

Вот один из примеров из практики — результат замены выгоды перед кнопкой заказа на лендинге. Вроде «мелочь», а конверсия подросла

Стоит заметить, что проводить эксперименты необходимо с изменением какого-то одного элемента — если поменяете сразу несколько, не поймете, что приносит пользу, а что, наоборот, тянет показатели вниз.

Еще один нюанс — при запуске новой рекламной кампании лучше сразу лить на несколько версий лендинга через сплит тест. Так Вы быстрее определите, какой вариант лучше работает и оставите его для дальнейшей открутки рекламы.

Реальные данные

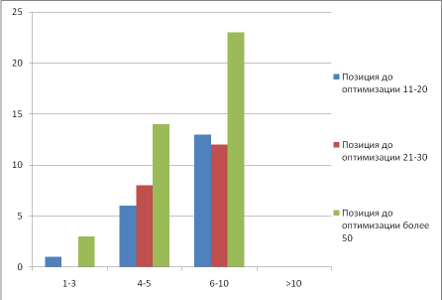

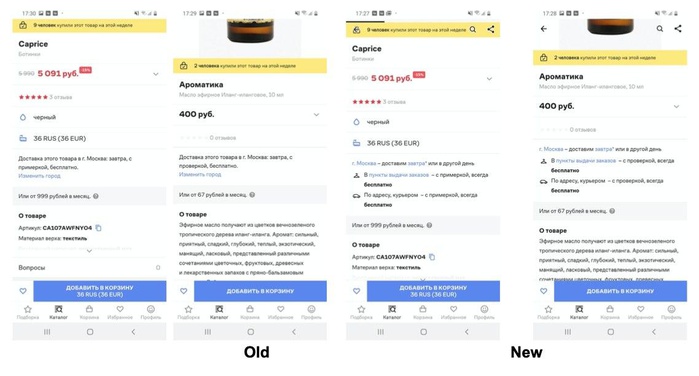

Рассмотрим два изображения с реальными продажами, модель обучена на нескольких годах ретроданых. Магазин номер один:

И магазин номер два:

на глаз

- вернуться на шаг отбора признаков и найти признак, который объяснит это поведение, вероятно какая то компания;

- применить детектор аномалий и выкинуть их рассмотрения те дни, в которых наблюдается аномальная ошибка; если ошибка будет систематическая, то они естественно не будут считаться аномалиями; так же выкидывание легко объясняется бизнесу, так как нововведение в виде выкладки пива должно иметь систематический характер, а не так, что в один какой то конкретный день, продажи скакнули, а в остальные дни не менялись.

Рассмотрим распределение ошибок для двух контрольных магазинов и одного тестового:

нормальнонормально

Далее объединяем все магазины тестовой группы в одну группу и все магазины контрольной в одну группу, чтобы можем делать, так выше мы предположили, что ошибка модели одинаково смещена для любого магазина. Получаем два распределения и проводим статтест.

Курс «Интернет-маркетолог» от TexTerra

| Длительность | 2,5 месяца |

| Уровень | С нуля |

| Для кого подходит | ● начинающим интернет-маркетологам; ● специалистам смежных digital-профессий; ● владельцам бизнеса |

| Формат | Видеолекции + домашнее задание + обратная связь от ментора |

| Гарантии | Помощь с трудоустройством |

| Итоги | Диплом + проекты в портфолио |

| Цена | Студентам предоставляются три тарифа: ● самостоятельный – 16 000 рублей; ● оптима – 32 000 рублей; ● премиум – 38 000 рублей. |

| Ссылка на курс |

Программа курса включает в себя следующие блоки:

Преподаватели:

Александр Белов — проектный директор компании, специалист в области аналитики и поисковой оптимизации сайтов.

Алёна Постоялко — руководитель отдела видеомаркетинга, маркетолог, графический дизайнер.

Лариса Волкова — ведущий SMM-специалист, эксперт по технической стороне социальных сетей.

После окончания курса вы сможете:

- работать с целевой аудиторией;

- производить анализ конкурентов;

- применять принципы бизнес-аналитики;

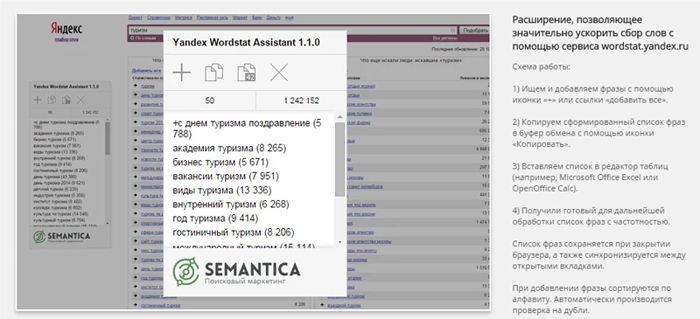

- работать с семантическим ядром;

- создавать контента для сайта;

- создавать и вести сообщества в соцсетях;

- работать с таргетированной рекламой;

- применять контекстную и медийную реклама;

- отслеживать и анализировать результаты стратегии.

Мои впечатления: Полный курс для тех, кто хочет расширить список своих компетенций в аналитической сфере или раскрутить свой бизнес. После обучения, вам не придётся обращаться за помощью к маркетологам — вы сами станете специалистом в этой области. В рамках курса каждый студент получает помощь от куратора и проекты для наполнения портфолио. Обучение проходит в онлайн формате два раза в неделю, что удобно для совмещения с учёбой и работой.

Результаты оценки качества метрик

| (a) | (б) | (в) |

| Рисунок 7. Результаты оценки качества для метрики успешности поисковых сессий: (а) — для исходной метрики и бутстрэпа по значениям, (б) — для исходной метрики и бутстрэпа по пользователям, (в) — для модифицированной метрики и бутстрэпа по значениям. |

| Пользователь | Значение метрики |

|---|---|

| Иван Иванович | |

| Иван Никифорович | |

| Антон Прокофьевич | 1 |

| Иван Иванович | 1 |

Модификация метрики

| Пользователь | Значение метрики |

|---|---|

| Иван Иванович | 0.5 |

| Иван Никифорович | |

| Антон Прокофьевич | 1 |

Элементы эксперимента

Контрольная группа. Тестирование предусматривает наличие контрольной группы, характеристики которой определяют аналитики и специалисты по большим данным при помощи математического анализа. Группы формируют так, чтобы они дублировали поведение пользователей всех сегментов аудитории Lamoda. Для конкретного эксперимента продакт-менеджеры могут выбрать группу из заранее сформированных по определенным правилам.

Тестовые группы. У нас есть возможность раскатить новую фичу, например, только на сотрудников и даже только на одного пользователя. Можно открыть эксперимент для разных сегментов аудитории: по странам, по платформам, по группам. Классическая схема: 50% аудитории выступают как контрольная группа, другие 50% — как тестовая.

Открывать новую фичу просто на всех пользователей без сложных схем тестирования не очень эффективно для большого бизнеса: мы не поймем, действительно ли конкретное изменение повлияло на общую выручку или конверсию в покупку, не сможем спрогнозировать дальнейшие точки роста.

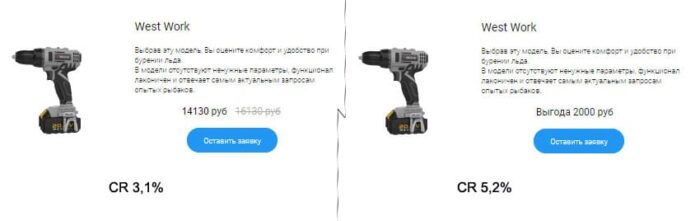

Вот так выглядит внутренняя админка сайта с двумя вариантами A/B-тестов.

Метрики. Стандартные метрики в A/B-тестировании — это срок, процент конверсии в покупку и рост выручки. Могут быть и чисто продуктовые метрики: в случае тестирования рекомендательной «полки» с товарами для пользователя нужно понять, сколько на ней должно быть карточек товара, удобно ли пользователю листать вбок.

В этом случае можно принять в качестве метрики количество карточек на полке рекомендаций. А при тестировании блока с возможностью оплаты с рассрочкой можно оценить и конверсию в покупку, и конверсию в заказ.

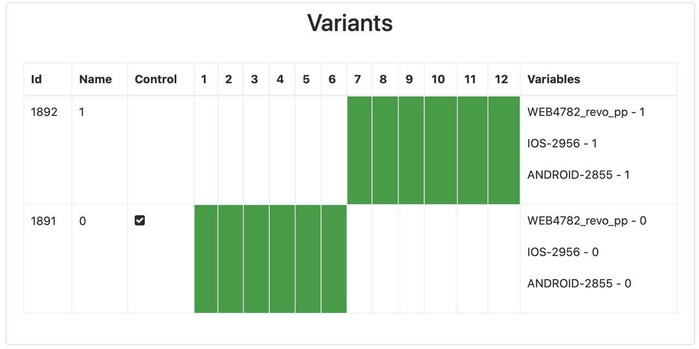

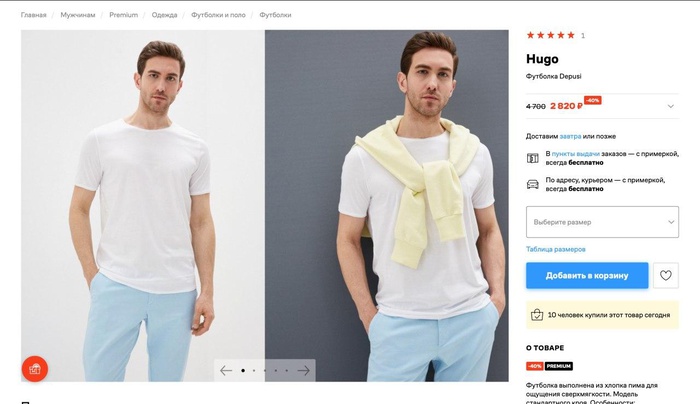

В блоке про доставку добавили информацию про условия бесплатной доставки.

Срок. Срок теста определяется исходя из перспектив набора статистической значимости — необходимого объема пользователей, которые бывают в разделе расположения новой фичи. В среднем наши тесты идут три-четыре недели. В менее посещаемых разделах эксперименты длятся дольше.

Пример эксперимента: перенос блока про доставку под кнопку «Добавить в корзину», так как исследование показало, что информация о выборе цвета и размера для пользователя важнее, чем информация о доставке.

Статистика нам в помощь

Чтобы понять, как устроен мир цифр и экспериментов, давайте немного разберём мат.часть. Если нет времени и сил, то советую пропустить этот раздел. Дальше, я дам более простые решения задачи.

Большой соблазн, когда получили результаты эксперимента, принять решение и всё, вот оно, “светлое будущее”. Но, ведь, если копнуть немножечко глубже, то за неделю распределение кликов по дням было неравномерным. Давайте распишем.

В таблице видно, что клики по дням распределены по-разному. А значит, наши значения варианта A и варианта B могут меняться каждый день. То есть, мы имеем дело со случайными величинами. Для таких случаев применяют средние значения. Но ведь, если мы проведем эксперимент ещё раз, то какова вероятность, что результат повториться?

Изобразим на графике распределение всех данных за неделю по варианту A и B.

Если мы возьмём средние величины по каждому из вариантов (это вертикальные полоски посередине двух волн), то увидим, что разница совсем невелика. Но существуют определенные отклонения, в большую и меньшую сторону от среднего. Поэтому, мы получаем пересечение двух волн. Чем оно больше, тем меньше значимость эксперимента и, соответственно, чем меньше пересечение, тем выше статистическая значимость.

Статистическая значимость, это то, насколько верны полученные результаты. То есть в нашем примере, ответ на вопрос “нужно ли брать вариант B?”.

Обычно, по-умолчанию принимают уровень значимости равный 95%. Это означает, что мы с 95% вероятностью хотим знать, стоит ли выбирать другой вариант (B) при сравнении. Оставшиеся 5%, это вероятность ошибки, которую мы допускаем или p-value в терминологии статистики.

Интересно, что многие забывают проверять уровень значимости в своих экспериментах и тем самым могут получать ошибочные данные. 8 из 10 AB тестов проходят мимо этой оценки. (источник)

Не буду вдаваться долго в подробности, как рассчитывается показатель значимости, просто дам инструмент, который посчитает все за вас.

Сервис #10

- Сервис: https://www.optimizely.com/

- Поддержка тестирования: А/В & MVT.

- Тарифные планы:

- $19, 2000 посетителей, 1 проект, таргетинг, персонализация, тестирование мобильных сайтов.

- $79, 20 000 посетителей, 2 проекта, кросс-браузерное тестирование.

- $399, 200 000, 5 проектов, мультивариантное тестирование, сегментация.

- Безлимитный тариф, геотаргетинг, история тестирования, IP-таргетинг, безлимитное число проектов.

- Шаблоны\редактор:онлайн-редактор.

- Демоверсия: 30 дней.

- Комментарии: В Safari глючит.

Приятный редактор, удобный интерфейс, понятная настройка целей тестирования.

Специально не стали здесь анализировать возможность проведения экспериментов в GA Experiments, так как его использование влечет создание вариантов страниц на вашей стороне, т.е. силами разработчиков, а здесь мы рассмотрели сервисы, с помощью которых даже далекий от кодинга человек сможет провести А/B-тестирование своего сайта.

Выводы

Наш фаворит: en.abtasty.com. Но при его использовании в определенный момент тоже возникли проблемы.

- Сначала начала слетать верстка элементов, которые не трогали в редакторе.

- Начали «мигать» тестовые варианты страниц, что сводило весь смысл рекламной компании на нет.

Самый дешевый сервис: http://www.convert.com/ (минимальный тарифный план — $9)

Самый длинный демопериод: http://unbounce.com/ и en.abtasty.com — по 30 дней.

Самые красивые шаблоны: http://lpgenerator.ru/

Меньше всего глючит: http://lpgenerator.ru/, http://unbounce.com/, http://landerapp.com/

Пользовались чем-то из вышеперечисленного? Какие впечатления? Еще что-то посоветовать можете? Пишите в комментарии, многим это интересно!

Perfomance-подход

Сейчас я расскажу о новом подходе, который избавляет от недостатков других методик.

Основа перфоманс-подхода в том, что нужно выбрать цель, адекватную бизнес-задачам. Например, увеличить конверсию.

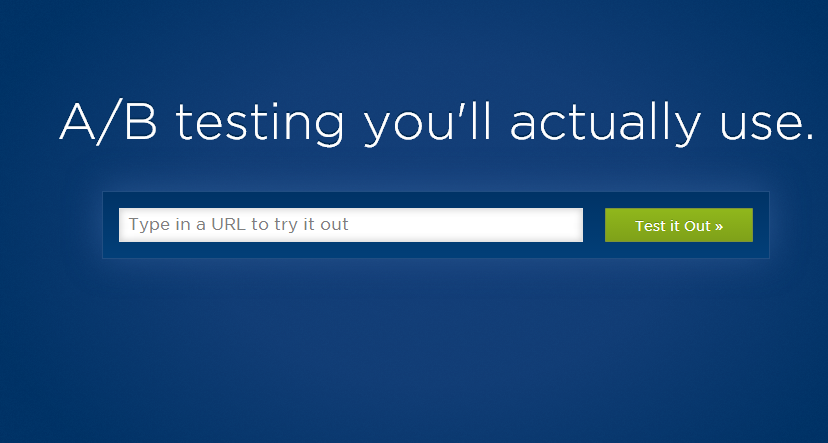

Цена спешки

Нам нужно ввести количественный показатель. Это одно из главных требований перфоманс-подхода в принципе.

В идеальном случае, мы проводим тест бесконечно долго и выбираем лучший вариант. Но на практике нам рано или поздно нужно прекратить тест.

Поэтому существует вероятность ошибки (1 – шанс_побить). Шанс побить – это качественная метрика, и нам нужно учесть, как сильно вредит конверсии наша ошибка. Нужно помножить вероятность ошибки на ожидаемые потери от нее. Назовем это число «ценой спешки».

Цена спешки – это ожидаемые потери при остановке теста сейчас по сравнению с бесконечно долгим тестом. Т.е. продолжение теста улучшит конверсию в среднем не более чем на цену спешки.

Допустим, мы откуда-то узнали, что с вероятностью в 50% у варианта А конверсия равна 9% и с вероятностью в 50% равна 20%. А у варианта B равновероятны следующие конверсии 10% и 11%. Какова цена спешки у А, т.е. ожидаемые потери при выборе варианта A?

Получим 4 равновероятный комбинации

|

A |

B |

Потери |

|

9% |

10% |

1% (10%-9%) |

|

9% |

11% |

2% (11%-9%) |

|

20% |

10% |

0 (20%>10%) |

|

20% |

11% |

0 (20%>11%) |

В среднем потери составляют (1%+2%)/4 = 0.75%

Схема тестирования

- Выбираем допустимую цену спешки. Например, 0.01%. Это допустимые средние потери в конверсии из-за спешки из-за того, что наше время ограничено.

- Раз в семь дней смотрим, достигли ли мы хотя бы по десять конверсий в обоих вариантах. В этом случае смотрим цену спешки. Ее можно посчитать.

- Если хотя-бы у одного из вариантов цена спешки меньше целевой, то останавливаем тест и выбираем вариант, в котором выше показатель конверсии.

Пример

Допустим, у нас есть сайт с конверсией 1% и 2000 кликов в день. Выбираем необходимую для завершения теста цену спешки. Например, 0.01%. Запускаем тест.

Через неделю получаем по 7000 кликов на каждом из вариантов. У первого варианта 66 конверсий, а у второго — 73. Вводим данные в:

Поскольку 0.0087%

Время тестирования

Время тестирования можно вычислить по очень простой формуле. Для каждого варианта в среднем нужно следующее число кликов:

100 * Конверсия/цена спешки

Например, если у нас конверсия равна 1%, а цена спешки 0.01%, то получаем 100*(1/0,01)=10.000. Для каждого варианта нужно по 10 тыс. кликов.

Сравнение эффективности

Наше время ограничено, причем у нас есть несколько изменений, которые нужно проверить. Поэтому задачу А/Б тестирования можно свести к оптимальному распределению времени между тестами.

С помощью R-Studio я провел 100.000 серий по 3 A/B теста, чтобы протестировать оптимальное условие остановки.

|

Недели |

Финальная конверсия |

|

|

Каждый тест длится 5 недель |

15 ∓0 |

1.37% |

|

Шанс побить > 80% |

14.8 ∓24 |

1.37% |

|

Цена спешки |

14.7 ∓7 |

1.40% |

|

Теоретический максимум |

бесконечность |

1.46% |

Что делать с результатами

Фиксировать

Это муторно и лениво, но необходимо. Если поленились однажды занести результаты в табличку, непременно их забудете, и тестирование пройдёт даром.

Если вы используете сервисы для A/B тестирования, то результаты сохраняются автоматически. Это удобно, но не решает всех проблем. Как правило, вам все равно придется фиксировать какие-то данные и синхронизировать их между собой.

Например, сервис тестирования покажет данные, кто именно посещал ваш проект, сколько кликов сделано и т.д., но финансовую информацию предстоит выгружать из AdSense, Travelpayouts и других источников.

Определить статистическую значимость

Статистическая значимость покажет, какова вероятность того, что такой же результат появился бы при проведении A/A-теста: сравнении страницы с самой собой. Если такая вероятность велика, значит результаты теста случайны и не показательны.

После определения статистической значимости нужно либо выбрать вариант-победитель и запустить в работу, либо оставить без изменений и задуматься, допущена ли ошибка в тестировании или изменение на странице ни на что не влияет. Следующий шаг — придумать новый тест. Пробуй, ошибайся, учись и снова пробуй — только такой подход в итоге приводит к результатам.

Использовать

Выбирайте вариант, который выиграл по результатам статистически значимого теста. Например, вы выявили, что поисковая форма с логотипом Aviasales конвертирует в продажи лучше, чем форма без опознавательных знаков – используйте первую.

Может оказаться, что исходный вариант A – лучше, чем тестовый вариант B. Это нормальная практика. Вы протестировали оба и нашли лучший. В этом случае, оставляйте исходный вариант и думайте над тем, что можно улучшить, а затем проводите следующий A/B тест.

A/B-тестирование мобильных приложений

Apptimize

apptimize.comтри способа

-

Визуальный (создается с помощью визуального редактора).

Позволяет в режиме реального времени с помощью визуального редактора изменить атрибуты элементов интерфейса (текст в UILabel, изображение в UIImageView). Измененное состояние будет новым вариантом: -

Блоки кода.

Позволяет варьировать выполнение операций, например: -

Динамические переменные.

Варианты формируются в зависимости от разных значений. Переменные объявляются вне класса с помощью макросовАльтернативные значения переменных задаются через веб-сайт. Например:

При создании вариантов есть возможность выбрать базу пользователей для тестирования.

Фреймворк позволяет логировать события:Также возможна агрегация событий других сервисов аналитики: Google Analytics, Mixpanel, Flurry, Localytics, Omniture.Цена и количество пользователей: есть ограниченная бесплатная версия, 300$/месяц до 100 000 пользователей, выше — не указано.

Optimizely

optimizely.com

- Визуальный

- Блоки кода

-

Переменные

Как видим, возможности c Apptimize идентичные. На первый взгляд, визуальный редактор Optimizely чуть менее функционален. Optimizely возможно интегрировать с Fabric, но сервис имеет достаточно скудный инструмент для аналитики.Цена и количество пользователей: цены не указаны, есть ограниченная бесплатная версия.

mixpanel.com

ПеременныеMPTweakValue

Визуальный редакторЦена и количество пользователей:

splitforce.comс блоками

Визуального редактораЦена и количество пользователей:

Зачем нужен A/A-тест (A/A/A-тест)

Мы делим всю аудиторию сайта на равные части, но не для того, чтобы им что-то показывать. Так мы определим время, которое необходимо для равномерного распределения пользователей по ключевым параметрам. Обычно A/A-тест длится 1-2 недели, за это время как раз можно спланировать и согласовать параметры A/B-теста (A/B/C-теста). Результат A/A-теста фиксируется в отчёте.

Практическую часть по настройке A/B-теста с помощью Google Analytics, Google Tag Manager и Яндекс Метрики вы можете посмотреть в записи вебинара на нашем Youtube-канале. Подсказки по настройкам вы также найдёте в презентации.

В нашем Телеграм-канале Маркетинг за три минуты мы пересказываем самые интересные материалы про онлайн-маркетинг в формате постов-трёхминуток — подписывайтесь и будьте в курсе. А если вы хотите поболтать и поделиться своими мыслями, приходите к нам в Чат Солдат.

Что такое А/Б-тестирование сайта

A/Б-тестирование – один из наиболее удобных способов маркетингового исследования, суть которого состоит в сравнении нескольких вариантов функционала или оформления веб-сайта по отношению к ожидаемому результату их введения. Иными словами, A/Б-тестирование позволяет произвести сравнительный анализ разных версий работы сайта. Метод также имеет название сплит-тестирование (от англ. – раздельное тестирование).

Цель тестирования – выявить, какой из вариантов изменения более эффективен. На самом деле их может быть гораздо больше двух.

Результатом A/Б-тестирования является вывод о целесообразности введения тех или иных изменений на сайте (интерфейса, дизайна, пунктов меню и проч.), основанный на оценке количественных показателей работы этих вариантов, сравниваемых между собой, которые, например, повысят конверсию, повлияют на уровень сбыта и увеличат прибыль.

Первоначальный этап сплит-тестирования выражается в анализе показателей уже существующей страницы. Ее мы принимаем за контрольный вариант А, который хотим улучшить. Приведем простой пример. Вы продаете товар через Интернет, но ваша продающая страница имеет конверсию всего 2%. Специалист по маркетингу не ставит заоблачных задач, он хочет увеличить конверсию лишь на два процента.

Это вполне выполнимо, нужно лишь найти правильное решение по изменению страницы. Маркетолог допускает вариант, что, изменив цвет кнопки «добавить в корзину» с зеленого на агрессивно красный, можно будет повлиять на увеличение заказов. Проверить это предположение можно, только создав измененную страницу В и оценив результат ее работы.

Рекомендуемые статьи по данной теме:

- Методы исследования в маркетинге: зачем, как, какой

- Автоматизация бизнес-процессов – реальная польза или лишняя головная боль?!

- Методы снижения затрат в компании и на предприятии без малых жертв

Веб-мастеру требуется разделить весь трафик страницы, подлежащей А/Б-тестированию, на две части. Одни пользователи будут попадать на вариант А, а другие – на новую страницу Б

Важно также учитывать источник трафика. Так, для объективности А/Б-тестирования разделяется поток посетителей из соцсетей, поисковиков и т.д

Поток из каждого источника в равных долях направляется на просмотр каждого варианта страницы.

Изучая метрику новой страницы по истечении установленного периода времени, специалист сравнивает коэффициент конверсии новой страницы с контрольной. Если он поднялся хотя бы на полпроцента, можно судить о более высокой эффективности предложенного варианта оформления страницы.

Однако, чтобы достигнуть повышения конверсии на ожидаемые два процента, нужно искать дальше. Маркетолог оставит кнопку ярко-красной, но подумает над необходимостью других изменений, которые могут положительно повлиять на конверсию. Как вы думаете, что он сделает? Снова будет использовать метод A/Б-тестирования. Но только за контрольную страницу будет принята обновленная версия с агрессивно красной кнопкой.

Объекты А/Б-тестирования

Сплит-тестирование ставит целью изменение метрики сайта. Объект тестирования может быть разным, он зависит от цели, которую преследует разработчик. А/Б-тестирование имеет прикладное назначение.

Специалисты сталкиваются с разными проблемами в работе веб-сайтов. Бывает, что большая часть трафика не задерживается на сайте и пяти минут, и все это из-за неудобного интерфейса. В некоторых случаях посетители сайта покидают его через пару секунд. Виной тому может быть неудачно выбранный шрифт. Но чтобы понять эти, казалось бы, мелкие и незаметные детали, нужно пробовать менять отдельные параметры сайта, проводя по ним А/Б-тестирование.

Вот еще пример. Сайт стремится увеличить количество подписчиков. Но расположение кнопки «подписаться» настолько незаметно, а цветовое оформление сайта так и не позволяет увидеть эту кнопку при беглом осмотре страницы, что никому и в голову не приходит, что она где-то есть. Отсюда крайне низкое количество подписчиков. А/Б-тестирование поможет определить наиболее удачный вариант кнопки, включая ее цветовое решение и местоположение.

А/Б-тестированию можно подвергать любые объекты, но все-таки чаще всего маркетологи сравнивают вариации следующих элементов:

- Внешний вид конверсионных иконок, их местонахождение на странице, размер и вид текста.

- Заголовок и описание товара.

- Заметность и привлекательность форм для конверсии.

- Дизайн страницы, расположение информации на ней.

- Цена продукта, дополнительные возможности по выгодному приобретению товара.

- Изображения продаваемых изделий.

- Объем текста на странице.

Вас также может заинтересовать: СTА-элементы, которые привлекут больше клиентов

Что тестировать на странице

Вы тестируете ваши гипотезы и предположения, как могло бы быть лучше, чем есть сейчас. Для этого в проект вносятся различные изменения в:

Дизайн сайта;

Оформление конкретной страницы;

Оформление отдельных элементов форм, виджетов, баннеров и т.д.

Размещение элементов на странице: форм, баннеров, кнопок.

Изображения товаров, картинки в статьях.

Текст: заголовки, описания продуктов, акций и специальных предложений, призывы на кнопках

Важно тестировать все параметры текста: содержание, количество, шрифт, размер, расположение текстовых блоков.

Функционал.. Всё это – большой плацдарм для гипотез, изменений и тестов

Например, вы можете проверить, как изменится поведение посетителей, если вы откажетесь от боковой колонки на сайте. Можно добавить обводку к рекламным блокам AdSense и проверить, к чему это приведёт и т.д

Всё это – большой плацдарм для гипотез, изменений и тестов. Например, вы можете проверить, как изменится поведение посетителей, если вы откажетесь от боковой колонки на сайте. Можно добавить обводку к рекламным блокам AdSense и проверить, к чему это приведёт и т.д.

Можно проводить и более глобальные тесты, например, сравнить – на какой домен лучше реагирует аудитория из контекстной рекламы: в национальной зоне .KZ или международной .COM. Это актуально, например, для работы на рынке Казахстана, где в 2018 году мы платили удвоенную комиссию. Удвоенная комиссия продлена, подробности здесь. Всё это, безусловно, расходует финансы и время, но позволяет выявить лучший вариант.

В рамках Travelpayouts вы можете протестировать:

- Партнёрские программы в одной нише. Например, у нас есть несколько автобусных партнёрок – попробуйте каждую и найдите ту, которая лучше работает именно у вас.

- Партнёрские программы в разных нишах. Определите, например, что предпочитают ваши посетители для путешествий по Европе: аренду машины или автобус.

- Партнёрские инструменты. Например, вы можете использовать различные форматы виджетов. Не останавливайтесь только на тесте формата рекламы, работайте с её расположением и тем, что её окружает. Интересный факт: Махо Кевлишвили – автор проекта aviabiletebi.org, менял поисковую форму более 10 раз, перед тем, как нашел лучший вариант. Узнайте больше про его опыт работы из нашего интервью.

Проводите эксперименты и за пределами Travelpayouts. Например, проверьте, где охотнее покупают авиабилеты: на Aviasales или Skyscanner, и какая партнёрская программа приносит вам больший доход.

Зачем тестировать разные варианты

Возможно, сейчас с 1000 посетителей сайта вы получаете 5 долларов, а можете получать 10, но пока не догадываетесь об этом. Чтобы узнать, какая стратегия может зарабатывать больше, как именно этого добиться и где потолок – проводятся тесты.

Перед началом тестирования нужно определить цель. Допустим, вы ваша цель: увеличить конверсию посетителей в продажи авиабилетов. Для этого вы пробуете разместить виджет календаря вместо классической поисковой формы.

Не все тесты связаны с ростом дохода. Вы можете тестировать расположение партнёрских инструментов и смотреть, как меняются поведенческие факторы – время на сайте, процент «дочитываний» и доля отказов. Что в конечном итоге может сказаться на количестве посетителей, которые возвращаются на ваш проект в течение месяца и т.д.

Какая бы цель у вас ни была в рамках A/B теста – всегда чётко определяйтесь с ней до начала теста.

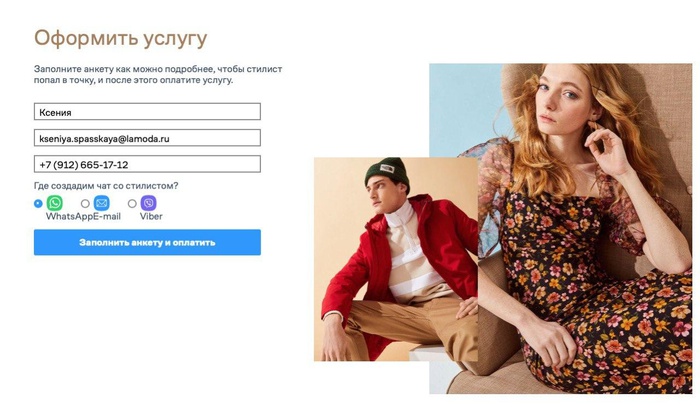

A/B-тестирование на примере сервиса «Стилист»

Оформление услуги

Покупатели готовы тратить все меньше времени на подбор гардероба и хотят делегировать этот процесс. На этой гипотезе Lamoda построила новый сервис «Стилист» и запустила первые тесты осенью 2019 года. Так платформа старается расширить свой образ онлайн-магазина до онлайн-советчика и проводника в мир моды и образа жизни.

Первой задачей было понять, нужен ли нам такой проект и куда двигаться, чтобы он работал эффективно. Первые тесты мы проводили на небольшой части сотрудников. Это был простой сервис на коленке: таблица Excel, чат в Telegram, два стилиста, которые собирали капсульный гардероб для участников эксперимента.

Семь тысяч сотрудников компании — отличная база для любых исследований, потому что сегментация примерно совпадает с особенностями аудитории платформы. Сделав первые выводы, мы разработали самый простой сервис и предложили протестировать его уже всем сотрудникам. Система работы стала сложнее. Мы ожидали, что запросы будут в основном от женщин, но 50% заявок поступило от мужчин. Сотрудники сами выкупали подобранные вещи и вели себя как реальные клиенты.

Тесты проходили до начала пандемии, а весной 2020 года нам пришлось их приостановить: в условиях распространения заболевания на наши метрики нельзя было полагаться. Поведение пользователей сильно изменилось, и мы наблюдали это на всех продуктах. Тестировать новый сервис в таких условиях было рискованно.

Эти отзывы помогли нам доработать коммуникацию и объяснить особенности нашей услуги. Мы усовершенствовали анкету, чтобы пользователь мог рассказать нам о своем гардеробе.

30 сентября 2020 года услуга стала доступна всем пользователям сервиса в тестовом режиме, эксперимент будет идти до конца октября. Пока результаты схожи с итогами нашего внутреннего тестирования. Единственное отличие: пользователей-мужчин немного меньше, чем внутри компании: 20% аудитории.

Нулевой итог работы

А/В

тест или сплит-тестирование не принесет успеха, если:

- В наличии нет постоянного трафика. Для грамотной работы инструмента следует наладить стабильный рост клиентской аудитории и постоянство совершения целевых действий на сайте.

- Проводить незначительное изменение элементов. Увеличение конверсии на 1-2 процента не принесет крупной прибыли. Лучше тщательно вникнуть в проблему и поработать над ее решением. Изучите клиентуру, конкурентные предложения и собственный продукт.

На

что стоит обратить внимание

Если

вы окончательно решили провести тестирование своего проекта, то поставьте

четкие цели и определитесь со стратегией и планом. Во время основного процесса

стоит придерживаться следующих рекомендаций:

- 1 изменение = 1 тест. Не

нужно метаться от одной детали к другой. Работайте последовательно, исправляя и

проверяя в отдельности каждый элемент; - размытые ожидания не принесут

успеха. Поставьте перед собой определенные результаты, которые должен принести

сплит-тест. Четко осознайте различия между письмами или макетами сайтов; - маленький срок = низкий

результат. Да, придется потратить достаточно сил и времени, чтобы проект мощно

заработал и принес небывалую прибыль. Если вы потратите на проработку деталей

меньше 3-х недель, то не получите ожидаемого прироста продаж; - не проводите эксперимент во

время праздников, массовых отпусков и периодов повышения заболеваемости

населения. В эти моменты люди не желают предпринимать серьезных шагов.

Сервисы

для АБ

тестирования

Google

Analytics предлагает популярный инструмент Content Experiments, позволяющий

проанализировать до пяти вариантов ваших страниц или писем.

Производительная

система равномерно распределит трафик по страницам, а удобный интерфейс и

необходимый справочный материал помогут более глубоко вникнуть в работу

сервиса.

Для

проведения тестирования можно применить другие ресурсы:

- Optimizely — известный

англоязычный инструмент. Характеризуется понятным интерфейсом и оплатой от 19

до 399$. При работе с этим сервисом не требуется знаний по работе с HTML; - RealRoi.ru — русскоязычная

система с простым, бесплатным и удобным пользованием.

Мы

рассказали все самое важное про AB тестирование. Теперь вы можете смело

проводить сплит-тест для увеличения продаж

Было полезно? Тогда оставляйте свои комментарии и делитесь с друзьями

информацией.