Что такое индексация сайта в поисковых системах и как её проверять

Содержание:

- Как закрыть сайт от индексации

- Что такое индексация заработной платы?

- Методы ускорения индексациии

- Определение

- Индексация сайта – что это значит

- дальнейшее чтение

- Различия индексации сайта в Google и «Яндексе»

- Особенности индексирования сайтов с разными технологиями

- Чем отличается индексация в Google и Яндекс?

- Как быстро проиндексировать сайт?

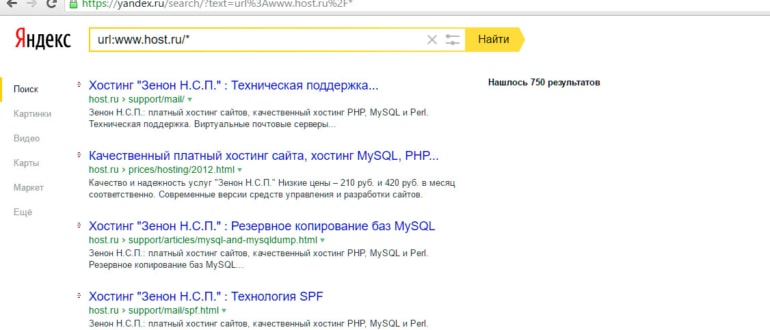

- Как происходит индексация сайта в Яндексе

- Что в итоге

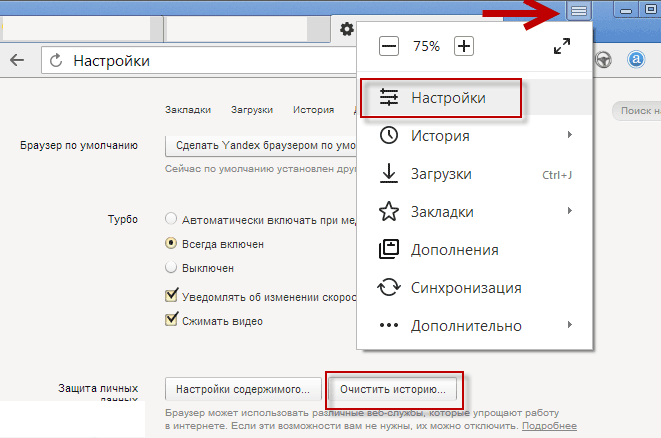

Как закрыть сайт от индексации

Для этого мы можем использовать два способа:

Через Robots.txt

Просто нужно удалить все содержимое этого файла, добавив вместо него:

User-agent: *

Disallow: /

С помощью этой строчки вы скажете всем поисковым роботам, что ваш ресурс индексировать не нужно – ни одной странички. Если до этого какие-то материалы попали в ранжирование – они будут удалены.

Также можно запретить индексацию для роботов какой-то отдельной поисковой системы. Для этого вместо звездочки, в User-agent: вы должны ввести название этого робота. Например, Yandex – для Яндекса, Googlebot – для Google.

Когда вы передумаете, вам нужно будет просто удалить этот код и добавить вместо него нормальное содержимое файла.

С помощью мета-тегов

На каждой странице должны быть размещены следующие мета-теги:

<meta name=»robots» content=»noindex, nofollow»/>

<meta name=»Yandex» content=»noindex, nofollow»/> – если хотим закрыть для какой-то конкретной ПС, то в поле name вставляем имя робота.

Разместить такие мета-теги можно при помощи плагина Yoast SEO. В нем есть отдельные параметры, которые отвечают за индексацию. Можно закрыть как отдельную страницу, так и весь ресурс в целом.

Закрывать от индексации отдельные страницы при помощи мета-тегов считается хорошим тоном. Это и проще, и быстрее – не надо по многу раз дополнять файл robots.txt.

Что такое индексация заработной платы?

С падением доходов из-за слабой национальной валюты знакомы не только пенсионеры. В статье 134 Трудового Кодекса есть отдельное указание на защиту работников от обесценивания денег путем постепенного повышения заработной платы, т. е. индексации. Также нормы индексации могут быть отдельно прописаны в коллективном договоре работников с работодателем.

В частном порядке индексация оговорена в отраслевых соглашениях работников железнодорожного транспорта и угольной промышленности – но в обоих случаях размер надбавок не должен быть ниже установленного индекса потребительских цен.

Право на своевременную индексацию имеют все без исключения трудящиеся (а не только занятые в государственном секторе). Разъяснения по этому поводу дали как Роструд, так и Конституционный суд России. В случае неисполнения работодателем своих обязательств, работник имеет согласно статье 353 Трудового кодекса право на защиту.

Для нарушителей – как должностных, так и юридических лиц – закон предусматривает штраф или приостановление деятельности.

Для определения размеров надбавок используются данные по инфляции как на федеральном, так и на региональном уровнях. Право определять периодичность индексации отдано на откуп каждому конкретному работодателю.

Для корректной индексации и наблюдения за уровнем инфляции составляется так называемый индекс потребительских цен.

Методы ускорения индексациии

Внеочередная индексация нового контента, соответственно, происходит вне основной очереди. Этим занимается быстробот, поэтому, чтобы он посетил сайт внепланово, его нужно завлекать на Интернет-ресурс. Это возможно с помощью правильной организации материала, а также наличия ссылки, по которой пользователи смогут перейти на сайт и прочитать нужную им информацию.

Если же необходимо ускорить индексацию основной выдачи, то нужно заметить, что скорость внесения информации в базу данных поисковика зависит от трастовости сайта. Поэтому, прежде всего, нужно наращивать траст.

Однако, все же есть приемы, помогающие сократить время попадания новой статьи к боту Яндекса:

- Необходимо выставлять на сайт новые (уникальные!) материалы с определенной периодичностью. Например, вы ежедневно будете размещать новую статью, бот «привыкнет» к этому и будет ждать очередного обновления (посещать интернет ресурс). Если долгое время не добавлять статьи, бот Яндекса перестанет заходить (помним о его самообучаемости).

- Все новые публикации необходимо добавлять в вебмастер «уникальные статьи». Это является своего рода сигналом боту. Не забываем добавлять ссылку в аддурилку вебмастера Яндекса.

Даются ссылки в социальные сети

Только если по ним будут переходить пользователи, это сработает, и бот будет обращать на них внимание.

- Пока робот не обнаружит новые статьи, ссылки на них должны находиться на главной странице сайта. В дальнейшем, когда бот Яндекса уже заметил их, такой необходимости больше нет. Материал не обязательно должен быть видим с главной страницы.

Инструмент оригинальные тексты в вебмастере

Инструмент оригинальные тексты в вебмастере

И еще высокоэффективный способ вызвать быстробота. Он заключается в следующем. Во-первых, нужен счетчик Яндекса на сайте, обладающий открытой возможностью передачи информации в индекс. Во-вторых, крайне желательно, чтобы «свежий» контент прочитало в день его публикации не менее 20-30 пользователей.

Читайте далее:

Проверка индексации сайта онлайн

Robots.txt и запрет индексации всего сайта

Быстрая индексация сайта в Гугле

Индексация ссылок

Склеивание зеркал сайта в поисковике Яндексе

Что-то с яндексом….

Определение

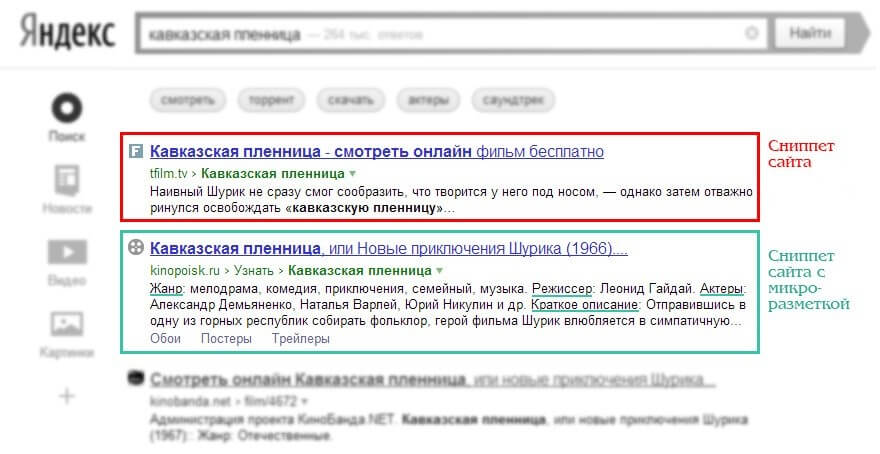

Представьте, что сайт – это документ или несколько документов с информацией. Поисковая система – сборник таких документов, работающий по определенным правилам. Он помогает пользователям в кратчайшие сроки найти документ с нужной информацией. Для этого необходимо проверить каждый документ, посмотреть, какого рода в нем информация, после чего разместить его где-то относительно других документов. Это и есть индексация.

Роботы приходят, сканируют весь контент, если все хорошо, – контент заносится в поисковые базы и начинает ранжироваться относительно других проектов.

После этого материалы попадают в поисковую выдачу. Позиция в поисковой выдаче может зависеть от качества материалов, самого ресурса, технической и внешней SEO-оптимизации и других факторов.

Поисковые системы заинтересованы в том, чтобы их пользователи получали качественные материалы в выдаче. По этой причине поисковая оптимизация претерпела очень много изменений за последние годы.

Раньше вебмастеры старались угодить роботам, делая свои проекты максимально “удобными” для индексации. Сейчас же роботы научились отличать “сеошный” бесполезный контент, от качественного и адекватного.

Поэтому для хорошей индексации не хватит простой SEO-оптимизации. Нужно понимать, что сейчас поисковые системы отдают предпочтение ресурсам с хорошими поведенческими факторами. Их можно добиться только при разработке проекта для людей.

За переоптимизацию или создание некачественного бесполезного контента ресурс может попасть под санкции. Это может включать в себя как простое снижение приоритета, так и полный запрет индексации со стороны поисковиков – материалы проекта удаляются из поисковых баз данных и больше никогда туда не попадают.

У каждой поисковой системы есть свои правила. В большинстве своем они почти ничем не отличаются, поэтому вебмастеры стараются оптимизировать свои проекты сразу и для всех.

Индексация сайта – что это значит

Индексация сайта – добавление веб-страниц в базу данных поисковиков. Сюда входят поиск страниц, анализ и добавление в каталог. Поисковые боты индексируют сайты в автоматическом режиме.

В частности, роботы собирают с веб-страниц всю имеющуюся на них текстовую информацию, структурируют ее и упорядочивают. Затем, по специальному алгоритму компьютер вычисляет, какие страницы наиболее подходят под тот или иной поисковый запрос, введенный пользователем, и выдают их ему в виде списка.

Однако сегодня все происходит намного сложнее. Роботы поисковых систем (их еще называют ботами) не просто считывают информацию с сайтов, но и анализируют ее: определяют полезность, доступность, читаемость страницы, размер текста и даже наличие ошибок в компьютерном коде. Все это влияет на то, с каким «рейтингом» страница окажется в индексе поисковика.

От этого «рейтинга» и зависит, будет ли эта страница выведена первой в списке, или же ее вовсе сделают недоступной для большинства пользователей из-за ее неуникальности или бессмысленного содержания.

У разных служб различаются алгоритмы индексации, но общее в них одно – страница или веб-сайт станут доступными в поиске только после того, как будут проанализированы ботом и внесены в базу данных.

дальнейшее чтение

- Р. Байер и Э. МакКрайт. Организация и обслуживание крупных заказных индексов. Acta Informatica, 173–189, 1972.

- Дональд Э. Кнут . Искусство компьютерного программирования , том 1 (3-е изд.): Фундаментальные алгоритмы, издательство Addison Wesley Longman Publishing Co., Редвуд-Сити, Калифорния, 1997.

- Дональд Э. Кнут . Искусство компьютерного программирования, том 3: (2-е изд.) Сортировка и поиск, Addison Wesley Longman Publishing Co., Редвуд-Сити, Калифорния, 1998.

- Джеральд Солтон . Автоматическая обработка текста, Addison-Wesley Longman Publishing Co., Inc., Бостон, Массачусетс, 1988.

- Джерард Солтон . Майкл Дж. Макгилл, Введение в современный поиск информации, McGraw-Hill, Inc., Нью-Йорк, 1986.

- Джерард Солтон . Леск, М.Е .: Компьютерная оценка индексации и обработки текста. Журнал ACM. Январь 1968 г.

- Джерард Солтон . Система поиска SMART — эксперименты по автоматической обработке документов. Prentice Hall Inc., Englewood Cliffs, 1971.

- Джерард Солтон . Преобразование, анализ и поиск информации с помощью компьютера, Addison-Wesley, Reading, Mass., 1989.

- Баеза-Йейтс, Р., Рибейро-Нето, Б .: Современный информационный поиск. Глава 8. ACM Press 1999.

- GK Zipf. Человеческое поведение и принцип наименьшего усилия. Аддисон-Уэсли, 1949.

- Адельсон-Велский, Г.М., Ландис, Е.М.: Алгоритм организации информации. ДАНСССР, 146, 263-266 (1962).

- Эдвард Х. Сассенгут-младший , Использование древовидных структур для обработки файлов, Коммуникации ACM, v.6 n.5, p. 272-279, май 1963 г.

- Харман, Д.К. и др .: Перевернутые файлы. В информационном поиске: структуры данных и алгоритмы, Прентис-Холл, стр. 28–43, 1992.

- Лим, Л. и др .: Характеризация изменения веб-документов, LNCS 2118, 133–146, 2001.

- Лим, Л. и др.: Динамическое ведение веб-индексов с использованием ориентиров. Proc. 12-й конференции W3, 2003 г.

- Моффат, А., Зобель, Дж .: Самоиндексирующиеся инвертированные файлы для быстрого поиска текста. ACM TIS, 349–379, октябрь 1996 г., том 14, номер 4.

- Мельхорн, К .: Структуры данных и эффективные алгоритмы, Springer Verlag, EATCS Monographs, 1984.

- Мельхорн, К. , Овермарс, М. Х . : Оптимальная динамизация разложимых задач поиска. IPL 12, 93–98, 1981.

- Мельхорн, К .: Нижние границы эффективности преобразования статических структур данных в динамические структуры данных. Математика. Теория систем 15, 1–16, 1981.

- Костер, М .: ALIWEB: Индексирование в Интернете по типу Archie. Компьютерные сети и системы ISDN, Vol. 27, No. 2 (1994) 175-182 (также см. Proc. First Int’l World Wide Web Conf., Elsevier Science, Amsterdam, 1994, pp. 175–182)

- Ян Х. Виттен, Алистер Моффат и Тимоти К. Белл. Управление гигабайтами: сжатие и индексирование документов и изображений. Нью-Йорк: Ван Ностранд Рейнхольд, 1994.

- A. Emtage и P. Deutsch, «Archie — Электронная служба каталогов в Интернете». Proc. Usenix Winter 1992 Tech. Conf., Usenix Assoc., Беркли, Калифорния, 1992, стр. 93–110.

- Д. Каттинг и Дж. Педерсен. «Оптимизация для обслуживания динамического инвертированного индекса». Труды 13-й Международной конференции по исследованиям и разработкам в области информационного поиска, стр. 405–411, сентябрь 1990 г.

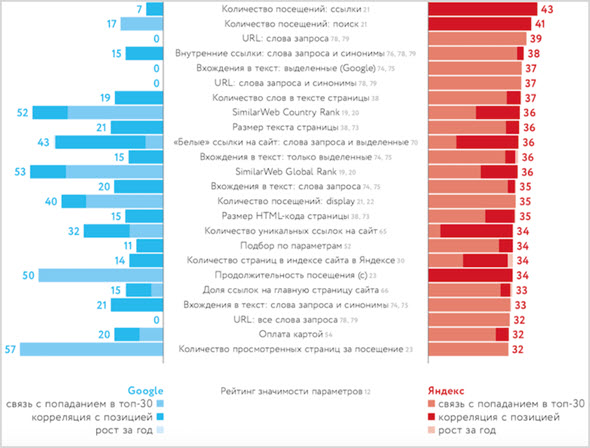

Различия индексации сайта в Google и «Яндексе»

Основное различие поисковых систем «Гугл» и «Яндекс» заключается в региональной принадлежности. Если Yandex работает только в русскоязычной части Интернета, то Google является международным поисковиком. Свои системы поиска есть практически в каждой стране. В некоторых случаях региональные сервисы могут составлять серьезную конкуренцию «Гуглу» («Яндекс» в РФ, Seznam – в Чехии, Baidu – в КНР и т. д.). Подтверждением этого факта могут служить переговоры по вопросам выкупа сервиса Yandex компанией «Гугл», которые имели место в 2003 году. Пока такое поглощение не состоялось.

У каждой поисковой системы есть свои программы ботов, осуществляющие проверку сайтов на предмет релевантности и качества представленного на них контента. При этом стандарты работы таких роботов постоянно совершенствуются. Нужно отметить, что разработчики не открывают полностью суть алгоритмов индексации, поэтому специалисты постоянно анализируют поисковые программы и на основании имеющихся практических данных формируют определенные выводы.

Рекомендуемые статьи по данной теме:

- Внутренняя оптимизация сайта: пошаговый разбор

- Проверка robots.txt: типичные ошибки и их устранение

- Редирект с http на https: повышаем безопасность сайта

Требования, которые предъявляют «Гугл» и «Яндекс» к индексации сайтов, имеют много общего. Поэтому можно сформулировать некоторые универсальные рекомендации:

Нужно уделять больше внимание качеству контента (уникальность, полезность и грамотность)

Программные и орфографические ошибки четко отслеживаются ботами и снижают индекс авторитетности сайта.

Интернет-площадки должны иметь понятную структуру

Важно, чтобы они были удобными для пользователей и содержали важную и ценную информацию.

Следует качественно проработать страницы контактов и обратной связи, разместить портфолио и отзывы, а также описать имеющиеся достижения.

На сайте нужно разместить работающие исходящие ссылки.

Контент на интернет-площадках должен постоянно обновляться, а их функционал следует дорабатывать с учетом различных нововведений и инноваций. Все это учитывается поисковиками при ранжировании сайтов.

Поисковая система «Яндекса» имеет два робота – основной и быстрый (Orange). Первый осуществляет индексацию Сети в целом, а второй обеспечивает возможность быстрого поиска наиболее свежей и актуальной информации по запросу пользователя. Каждый робот имеет перечень данных, которые необходимо проиндексировать.

По мнению экспертов, «Яндекс» работает медленнее, чем «Гугл». Но при этом поисковая система Рунета индексирует полезные материалы и исключает из выдачи «лишние» результаты.

Преимущество «Гугла» заключается в его универсальности. «Яндекс» же развивается исключительно в русскоязычном Интернете (попытки выйти на другие рынки имели место, но пока не увенчались успехом).

Система Yandex ориентирована на поиск по запросам из ограниченного перечня регионов. Но именно региональный характер во многом определяет его успешность. В настоящее время «Гугл» и «Яндекс» занимают в русскоязычном Интернете примерно одинаковые ниши.

В интернет-пространстве других стран поисковая система Yandex не получила распространение, так как наиболее значимыми факторами поиска там выступают язык и местонахождение пользователя. На основании этих критериев и строится поисковая выдача «Гугла». В системе «Яндекс» индексация по языковым признакам не происходит. Несмотря на то, что этот поисковик определяет место нахождения пользователя, он не учитывает этот фактор при обработке запроса. Классифицировать сайты Рунета по регионам в зависимости от языка запроса не получается. «Яндекс» может настраивать поисковую выдачу исключительно по территориальному признаку, в чем и заключается уникальность этой системы.

Не так давно Yandex запустил новый инструмент – поиск «Андромеда». После этого поисковик предлагает определенные места в городах, дает возможность собирать коллекции пользователя, информирует о событиях из мира спорта, отмечает статус интернет-ресурсов особыми значками в зависимости от их благонадежности и популярности. Каким образом новый инструмент может влиять на индексацию, еще не совсем ясно.

Важным нововведением 2018 года является замена показателя ТИЦ (индекс цитирования) на ИКС (индекс качества сайта). Новый показатель необходимо учитывать при продвижении ресурса.

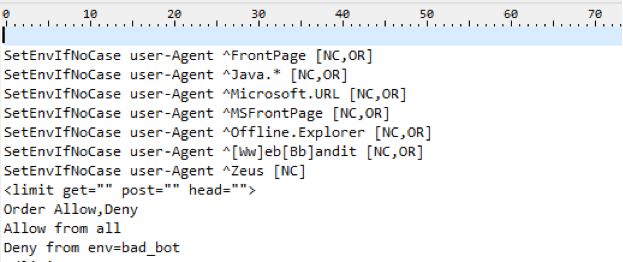

Особенности индексирования сайтов с разными технологиями

Ajax

Сегодня все чаще встречаются JS-сайты с динамическим контентом ― они быстро загружаются и удобны для пользователей. Одно из основных отличий таких сайтов на AJAX — все содержимое подгружается одним сплошным скриптом, без разделения на страницы с URL. Вместо этого ― страницы с хештегом #, которые не индексируются поисковиками. Как следствие — вместо URL типа https://mywebsite.ru/#example поисковый робот обращается к https://mywebsite.ru. И так для каждого найденного URL с #.

В этом и кроется сложность для поисковых роботов, потому что они просто не могут «считать» весь контент сайта. Для поисковиков хороший сайт ― это текст, который они могут просканировать, а не интерактивное веб-приложение, которое игнорирует природу привычных нам веб-страниц с URL.

Буквально пять лет назад сеошники могли только мечтать о том, чтобы продвинуть такой сайт в поиске. Но все меняется. Уже сейчас в справочной информации и Google, и Яндекс есть данные о том, что нужно для индексации AJAX-сайтов и как избежать ошибок в этом процессе.

Сайты на AJAX с 2019 года рендерятся Google напрямую — это значит, что поисковые роботы сканируют и обрабатывают #! URL как есть, имитируя поведение человека. Поэтому вебмастерам больше не нужно прописывать HTML-версию страницы.

Но здесь важно проверить, не закрыты ли скрипты со стилями в вашем robots.txt. Если они закрыты, обязательно откройте их для индексирования поисковыми роботам

Для этого в robots.txt нужно добавить такие команды:

Поисковые роботы Яндекса тоже могут индексировать сайты на AJAX, но при одном условии ― если у каждой страницы сайта есть HTML-версия. В справочнике Яндекса можно узнать подробнее, как сообщить роботу об HTML-версии страницы.

Флеш-контент

С помощью технологии Flash, которая принадлежит компании Adobe, на страницах сайта можно создавать интерактивный контент с анимацией и звуком. За 20 лет своего развития у технологии было выявлено массу недостатков, включая большую нагрузку на процессор, ошибки в работе флеш-плеера и ошибки в индексировании контента поисковиками.

В 2019 году Google перестал индексировать флеш-контент, ознаменовав тем самым конец целой эпохи. Поисковые роботы Яндекса индексируют только тот текст во Flash-документах, который размещен в таких блоках: DefineText; DefineText2; DefineEditText; Metadata.

Поэтому не удивительно, что поисковики предлагают не использовать Flash на ваших сайтах. Если же дизайн сайта выполнен с применением этой технологии, сделайте и текстовую версию сайта. Она будет полезна как пользователям, у которых не установлена совсем или установлена устаревшая программа отображения Flash, пользователям мобильных устройств (они не отображают flash-контент), так и поисковым роботам Яндекса.

Фреймы

Фрейм это HTML-документ, который не содержит собственного контента, а состоит из разных областей ― каждая с отдельной веб-страницей. Также у него отсутствует элемент BODY.

Как результат, поисковым роботам просто негде искать полезный контент для сканирования. Страницы с фреймами индексируются очень медленно и с ошибками.

Вот что известно от самих поисковиков: Яндекс индексирует контент внутри тегов <frameset> и <frame> и не индексирует документы, подгружаемые в тег <iframe>. А вот Google может индексировать контент внутри встроенного фрейма iframe. Именно iframe поддерживается современными технологиями, так как он позволяет встраивать фреймы на страницы без применения тега <iframe>.

А вот теги <frame>, <noframes>, <frameset> устарели и уже не поддерживаются в HTML5, поэтому и не рекомендуется использовать их на сайтах. Ведь даже если страницы с фреймами будут проиндексированы, то трудностей в их продвижении вам все равно не избежать.

Чем отличается индексация в Google и Яндекс?

Индексация сайта в Google

Когда мы гуглим что-то, поиск данных ведется не по сайтам в режиме реального времени, а по индексу Google, в котором хранятся сотни миллиардов страниц. Во время поиска учитываются разные факторы ― ваше местоположение, язык, тип устройства и т. д.

В 2019 году Google изменил свой основной принцип индексирования сайта — вы наверняка слышали о запуске Mobile-first. Основное отличие нового способа в том, что теперь поисковик хранит в индексе мобильную версию страниц. Раньше в первую очередь учитывалась десктопная версия, а теперь первым на ваш сайт приходит робот Googlebot для смартфонов — особенно, если сайт новый. Все остальные сайты постепенно переходят на новый способ индексирования, о чем владельцы узнают в Google Search Console.

Еще несколько основных отличий индексации в Google:

- индекс обновляется постоянно;

- процесс индексирования сайта занимает от нескольких минут до недели;

- некачественные страницы обычно понижаются в рейтинге, но не удаляются из индекса.

В индекс попадают все просканированные страницы, а вот в выдачу по запросу — только самые качественные. Прежде чем показать пользователю какую-то веб-страницу по запросу, поисковик проверяет ее релевантность по более чем 200 критериям (факторам ранжирования) и отбирает самые подходящие.

Индексация сайта в Яндекс

В Яндексе процесс индексирования в целом такой же. Поисковые роботы заходят на сайт, загружают и обрабатывают данные, после чего добавляют их в индекс для дальнейшего использования в выдаче.

Что еще важно знать про индексацию в Яндекс:

- индекс Яндекса обновляется во время обновлений поисковой базы (примерно раз в три дня);

- процесс индексирования сайта занимает от недели до месяца;

- Яндекс работает медленнее, чем Гугл, но при этом удаляет некачественные страницы из индекса, отбирая только полезные материалы.

В выдачу Яндекса попадают те страницы, которые максимально отвечают на поисковый запрос, содержат понятную и полезную информацию и удобны в использовании.

Что поисковые роботы делают на вашем сайте, мы разобрались, а вот как они попадают туда? Существует несколько вариантов.

Как быстро проиндексировать сайт?

Поисковые системы могут выполнять индексацию сайта двумя главными способами:

- Поисковый робот самостоятельно по истечении некоторого времени определяет новый ресурс или его конкретные страницы. Чтобы индексация все-таки произошла, на других индексируемых сайтах должны присутствовать активные ссылки. Но в этом случае нужно быть готовыми к тому, что придется ждать какое-то время, пока поисковый бот посетит ваш интернет ресурс.

- Можно вручную добавить единый указатель ресурса (URL) в форму поисковой системы. Достаточно добавление только главной страницы ресурса – и все внутренние страницы сайта тоже будут обрабатываться. После таких манипуляций сайт автоматически становится в очередь на индексацию.

В принципе, важна не только индексация сайта, а и то, какое место в рейтинге поисковой системы он занимает. Наверное, понятно, что наибольшее количество посетителей обычно у тех сайтов, которые находятся в топ-10 (перечне из первых десяти индексов, находящихся на первой странице поисковой выдачи). Поэтому следует как можно больше стараться, чтобы интернет ресурс и его материалы попали в эту первую десятку.

Как происходит индексация в Яндексе

Прежде всего, нужно учитывать, что сайт может проиндексироваться Яндексом только в том случае, если он открыт для этой поисковой системы.

Роботы Яндекса функционируют следующим образом:

- К боту поступает сигнал о том, что нужно проверить сайт. Проверка может выполняться планово или же внепланово (быстроботом), то есть благодаря тому, что ему дается определенный сигнал. Этот этап очень важный. От него во многом зависит успех индексации.

- Когда робот все-таки посетил сайт, он, прежде всего, проверяет служебные данные, просматривает уже имеющийся контент на предмет обновлений и смотрит новые материалы (если такие имеются).

- При обнаружении новых и обновленных данных робот загружает их себе, затем покидает сайт.

- Выполняет передачу данных главному роботу, который в дальнейшем обрабатывает полученную информацию.

Индексация поисковой системой Яндекс обладает своими особенностями. Самая главная заключается в том, что в ней все этапы четко разделены. Когда бот заходит на сайт, он всего-навсего считывает информацию. Сама же индексация происходит гораздо позже. Что требуется от нас?

Прежде всего, дать поисковому роботу новую статью или какой-то другой необходимый контент и то ли ждать, пока процесс обработки и внесения информации в базу данных поисковика произойдет без дополнительных вмешательств, или же попытаться ускорить индексацию. Как это сделать? Об этом далее.

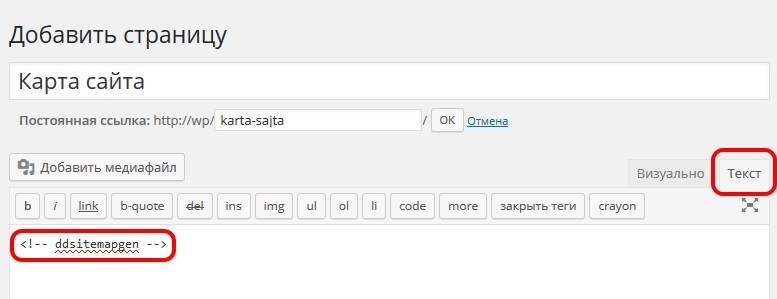

Добавление url новой страницы в вебмастер яндекса

Как происходит индексация сайта в Яндексе

Индексирование сайта в Яндексе – это обход роботами поисковой системы yandex Вашего сайта, и внесения всех открытых страниц в базу. Паук русского поисковика добавляет в базу данные о сайте: его страницах, картинках, видео, документах, которые доступны для поиска. Также, поисковой бот занимается индексированием ссылок и других элементов, что не закрыты специальными тегами и файлами.

Основные способы индексации ресурса:

-

Принудительная — следует отправить сайт на индексацию в Яндекс через специальную форму.

-

Естественная — поисковому пауку удается самостоятельно найти Ваш сайт, переходя с внешних ресурсов, что ссылаются на вебсайт.

Это зависит от множества факторов: какие значения стоят в Sitemap.xml, как часто наполняется ресурс, как часто упоминание о сайте появляется на других ресурсах. Процесс индексации цикличен, поэтому робот будет приходить к Вам через (практически) равные промежутки времени. А вот с какой периодичностью — зависит от упомянутых выше факторов и конкретного робота.

Порой на проекте могу возникнуть технические неполадки (или проблемы с сервером), в таком случае yandex индексация сайта не состоится, из-за чего поисковая система может прибегнуть к следующему сценарию:

- сразу выкинуть непроиндексированные страницы с базы;

- провести переиндексацию ресурса через определенное время;

- поставить страницы, что не были проиндексированы, на исключение из базы, и если не обнаружит их при повторной индексации, то выбросит из индекса.

Что в итоге

Поисковые системы готовы проиндексировать столько страниц вашего сайта, сколько нужно. Только подумайте, объем индекса Google значительно превышает 100 млн гигабайт ― это сотни миллиардов проиндексированных страниц, количество которых растет с каждым днем.

Но зачастую именно от вас зависит успех этого мероприятия. Понимая принципы индексации поисковых систем, вы не навредите своему сайту неправильными настройками. Если вы все правильно указали в robots.txt и карте сайта, учли технические требования поисковиков и позаботились о наличии качественного и полезного контента, поисковики не оставят ваш сайт без внимания.

Помните, что индексирование ― это не о том, попадет ваш сайт в выдачу или нет. Намного важнее ― сколько и каких страниц окажутся в индексе, какой контент на них будет просканирован и как он будет ранжироваться в поиске. И здесь ход за вами!

Просмотры:

15 901

Юлия Торчинская

Юлия — контент-маркетолог c 10-летним опытом работы в журналистике, копирайтинге, рекламе и PR.

Своим опытом и знаниями она делится, создавая полезные статьи про SEO и диджитал-маркетинг для блога SE Ranking и популярных медиа.

Когда Юлия не пишет статьи, она осваивает новые асаны, путешествует и помогает волонтерской организации YWCA.